日常生活の中に機械学習を活用したAIシステムやアプリケーションが浸透して久しいですが、それらは本当に適切な動作をしているのか、差別的な振舞いはしていないか、ということに疑問を持ち始めた方もいらっしゃるのではないでしょうか。余暇に鑑賞する映画のレコメンドや海外の記事を読むために用いる機械翻訳ツールなどの身近なものから、ローン申請や雇用など人生を変えるような重大な意思決定の中にも機械学習アルゴリズムは使用されています。例えば、雇用の場合を考えてみると、性別によって採用か否かの意思決定の結果が変わることは不公平ですよね。このような機械学習技術の中に潜む不公平性に対処するにはどうしたらよいのでしょうか。本ブログでは、この疑問に対するアプローチのいくつかを紹介していきたいと思います。 この技術ブログは3部構成になっています。第1部では、公平性とはどのようなものなのか、不公平はどのようにして起きるのか、という基本的な部分を扱っていきます。ここでは、数式は登場しないのでどなたでも公平性に親しんでいただけると思います。第2部では、数式も用いつつ公平性が満たされるとはどのようにして定式化できるのか、不公平を緩和するためにはどのような方法があるのか、について技術的な部分を扱っていきます。第3部では、公平性のための実用的なツールをいくつか紹介し、実際にツールを用いて不公平性の検出と対処を行います。 この解説は、「A Survey on Bias and Fairness in Machine Learning」という公平性に関するサーベイ論文と学会誌「人工知能」のVol.34 No.2に寄稿されている記事「機械学習・データマイニングにおける公平性」に基づいていますが、適宜他の論文などからも引用しています。その際は情報元を記載してあります。また、第6章で扱うFairlearnを用いた実装では、FairlearnのGitHubにあるノートブック「Binary Classification with the UCI Credit-card Default Dataset」を参考にしています。

目次

公平性とは何か

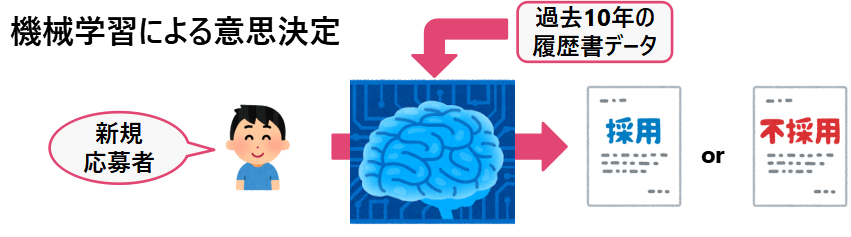

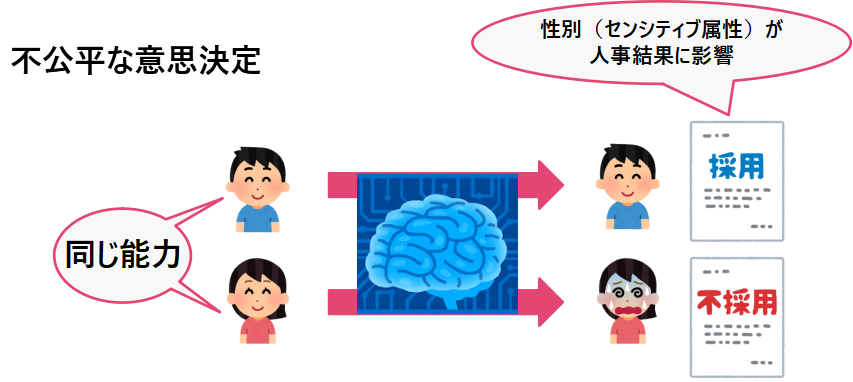

公平性とは、意思決定の文脈において、先天的または後天的な特徴に基づいて、個人またはグループに対する偏見あるいは好意がないこと、とされています。例えば、2018年に使用を打ち切られた米Amazon.com, Inc(以下、Amazon)のAIを用いた人材採用システムを例に公平性を考えてみましょう。Amazonは優秀な人材を採用するために、過去10年間の履歴書のパターンを機械に学習させ、新規応募者(の履歴書)にスコア付けを行いました。しかし、技術系の職種では過去の採用実績が男性に偏っており、例えば、「女性チェス部の部長」や「女子大卒業生」など女性を示唆する単語が履歴書に含まれている場合に評価を下げる傾向が見られました。これは性別という先天的(後天的である可能性もある)な特徴に基づいて女性に偏見の眼差しを向け、男性を好意的に捉えた結果と言えます。このような価値観は現代にはそぐわないのではないでしょうか。

先ほどの例では、性別という属性の誤った利用によりもたらされた不公平を見ました。このような属性をセンシティブ属性(sensitive attribute)などと呼びます。センシティブ属性にはどのようなものがあるでしょうか。AIシステムの利用領域ごとにセンシティブ属性の規準が異なる可能性があるが、1つの規準として米国の公正住宅法(FHA)およびクレジットカード差別撤廃法(ECOA)の中で定められているセンシティブ属性を紹介します。下表に登場するCCPAとは、カリフォルニア消費者プライバシー法を指します。

先ほどの例では、性別という属性の誤った利用によりもたらされた不公平を見ました。このような属性をセンシティブ属性(sensitive attribute)などと呼びます。センシティブ属性にはどのようなものがあるでしょうか。AIシステムの利用領域ごとにセンシティブ属性の規準が異なる可能性があるが、1つの規準として米国の公正住宅法(FHA)およびクレジットカード差別撤廃法(ECOA)の中で定められているセンシティブ属性を紹介します。下表に登場するCCPAとは、カリフォルニア消費者プライバシー法を指します。

| 属性 | FHA | ECOA |

|---|---|---|

| 人種 | ✓ | ✓ |

| 肌の色 | ✓ | ✓ |

| 国籍 | ✓ | ✓ |

| 宗教 | ✓ | ✓ |

| 性別 | ✓ | ✓ |

| 家計の地位 | ✓ | |

| 障害の有無 | ✓ | |

| CCPAに基づく権利の行使 | ✓ | |

| 既婚かどうか | ✓ | |

| 公的援助の有無 | ✓ | |

| 年齢 | ✓ |

この表を見てみると人種や肌の色など人権に関わる重大な属性があり、AIシステムはこれらを侵害しないように設計されるべきです。しかし、前述のAmazonの例以外にも不公平を引き起こしたAIシステムの実用例が存在します。ここでは、2つの事例を紹介します。

事例1. 再犯予測プログラムCOMPAS

COMPASとは機械学習アルゴリズムを用いた再犯予測プログラムであり、米国では実際に裁判の判決や仮釈放の判断などに用いられています。2016年に米調査報道メディアのProPublicaがCOMPASに対して次の指摘をしました(外部リンク)。端的に言うと、黒人に対しては誤検知をしやすく、白人に対しては見逃しが多い、というものです。具体的な数値をProPublicaの報告に基づき下表に記しました。

| 白人 | アフリカ系アメリカ人 | |

|---|---|---|

| 2年以内に再犯しなかった人が再犯すると誤って予測される確率 | 23.5% | 44.9% |

| 2年以内に再犯した人を再犯しないと誤って予測する確率 | 47.7% | 28.0% |

上表を見ると、再犯に対する誤検知がアフリカ系アメリカ人の方が白人より2倍ほど高くなっていることが分かります。アフリカ系アメリカ人の犯罪率が高いという事実があるため黒人に対して高スコアをつけること自体は問題ではないが(程度に依る)、アフリカ系アメリカ人への誤検知率が高いことや白人への見逃し率の高さから、この2つのグループに対してCOMPASは公平な振舞いをしていないと言えます。

事例2. 顔認識プログラム

2018年にMITのJoy Buolamwini氏らは、Microsoft、Face++、IBMがそれぞれ提供している顔認識オンラインサービスに対して、肌の色が明るい男性のエラー率は1%未満だったのに対して、肌の色が暗い女性に対する誤検知率が20~35%と相対的に高くなることを報告しました。(外部リンク)。これは顔認識システムに用いられる既存のデータセットの大部分が肌の色が明るい男性の顔であることが原因でした。 上記の顔認識プログラムの問題は、2020年5月に起きた白人警官による黒人男性暴行死事件を契機とした人種差別抗議運動の影響も重なり大きな動きを見せました。各社は顔認識技術について以下の発表をしました。

| IBM | 汎用的な顔認識および分析のためのソフトウェア製品を廃止すると発表。 |

| Amazon | 顔認識技術「Rekognition」の警察による使用を1年間停止すると発表。 |

| Microsoft | 顔認識技術を統制する米国の人権法が制定されるまで、米国の警察に顔認識技術を販売しないことを決定。 |

このように、人権に関わるような重大な公平性が保証されていないことが発覚したAIシステムはサービスを停止せざるを得なくなる、あるいは当該分野からの事業撤退を余儀なくされる場合もあります。したがって、持続的なAIシステムを供給するためには、一人ひとりが公平性に関するリテラシーを持つ必要があります。

公平性とは何か

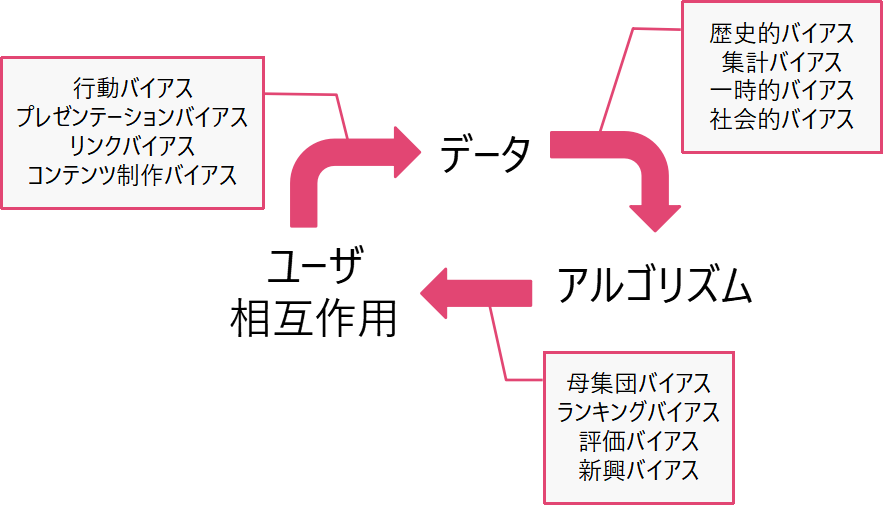

不公平が起こる原因は様々なバイアスにあります。バイアスの分類をデータごとにあるいはアルゴリズムごとに分けて分類することは難しいことが分かっています。というのも、一般的なAIシステムのワークフローでは、データから機械学習モデルを作成し、このモデルを利用して意思決定がなされ、その結果が将来の学習用データに影響を及ぼす、というフィードバックループ現象が存在するからです。さらに、データとアルゴリズム間のフィードバックループに加え、アプリケーションの利用者の振舞いも考慮に入れる必要があります。以上を反映したのが下図のフィードバックループ図です。このワークフローに沿った矢印ごとに最も適切と思われるバイアスが配置されています。  いくつかのバイアスを例を通して紹介します。

いくつかのバイアスを例を通して紹介します。

■歴史的バイアス(Data to Algorithm)

データが完全な状態で測定およびサンプリングされたとしても、そのデータから作成されたアプリケーションなどが、歴史的事実に基づいたあるがままの世界を反映してしまい、望ましくない結果を生み出す場合に発生します。

例:画像検索

米Fortune誌は年に1回、全米上位500社をその総収入に基づきランキングするリストを編集・発行しています。2018年にこのリストに登場する女性CEOは全体の5%でした。女性CEOが少ないという歴史的事実から、「CEO」で画像検索をした結果は男性CEOに偏ることが予想されます。しかし、この事実はアプリケーションの検索結果に反映されるべきではないかもしれません。実際に、GoogleはCEOの画像検索を女性の割合が高くなるように修正を加えました。

■表現バイアス

データのサンプリング方法が母集団の特定のグループのみしか対象に取らない場合、あるいはトレーニングで使用した母集団と異なる母集団を対象とした場合に発生します。

例:ImageNet

ImageNetは12万枚のラベル付き画像から成る画像データセットです。このデータセットに含まれている画像は約45%が米国で撮影されたものであり、残りの大多数はヨーロッパからで撮影されたものです。中国とインドで撮影された画像はそれぞれ1%と2.1%です。ImageNetで学習された分類器に対して、「パキスタンやインド」の予測結果と「北米や西ヨーロッパ」の予測結果とを比較すると、いくつかのカテゴリ(花婿・花嫁(bridegroom)など)で性能が劣ることが報告されています。

■測定バイアス

予測に使用する特定の特徴量やラベルを選択、収集および計算する場合に発生します。

例:COMPAS

警察による予測的な取り締まりでは、「逮捕」はしばしば「犯罪」のプロキシとして用いられます。しかし、マイノリティ集団に対しては警察の取り締まりが厳しく、検挙率がコミュニティごとに異なる可能性があります。再犯予測プログラムCOMPASでは、過去の逮捕歴や友人・家族の逮捕歴がプロキシとして用いられ、測定の仕方の差異によるバイアスを生じさせました。これは黒人と白人の被告人間での高い誤検知率に繋がりました。

■評価バイアス(Algorithm to User Interaction)

アルゴリズムの検証用データやベンチマークが対象となる母集団を代表していない場合に発生します。

例:顔認識アルゴリズム

実利用されている顔認識アルゴリズムに対して、肌の色の暗い女性に対する性能が著しく悪いことが報告されています。これはベンチマークとして使用されたデータに偏りがあったため、特定の集団に対してパフォーマンスが下がることが見抜けなかったことが原因と考えられます。

■プレゼンテーションバイアス(User Interaction to Data)

ユーザーがUIからの情報の提示のされ方により偏った行動をする場合に発生します。

例:Webアプリケーション上でのクリック数

Web上で見たものしかユーザーはクリックを行えないので、UIが表示したものはクリックされる可能性があり、それ以外はクリックされることはありません。また、ユーザーはWeb上のすべての情報を見ているわけでもありません。

■その他のバイアス

・集計バイアス(Data to Algorithm)

・母集団バイアス(Algorithm to User interaction)

・シンプソンのパラドクス

・断片的データの誤り

・サンプリングバイアス

・行動バイアス(User Interaction to Data)

・コンテンツ制作バイアス(User Interaction to Data)

・リンクバイアス(User Interaction to Data)

・一時的バイアス(Data to Algorithm)

・人気バイアス

・アルゴリズムバイアス

・ランキングバイアス(Algorithm to User interaction)

・社会的バイアス(Data to Algorithm)

・新興バイアス(Algorithm to User interaction)

・自己選択バイアス

・変数消去バイアス

・因果バイアス

・観測者バイアス

・資金調達バイアス 詳細については、A Survey on Bias and Fairness in Machine Learningやこの中で紹介されているreferenceから元論文を参照してください。