目次

はじめに:企業での生成AI活用の現状

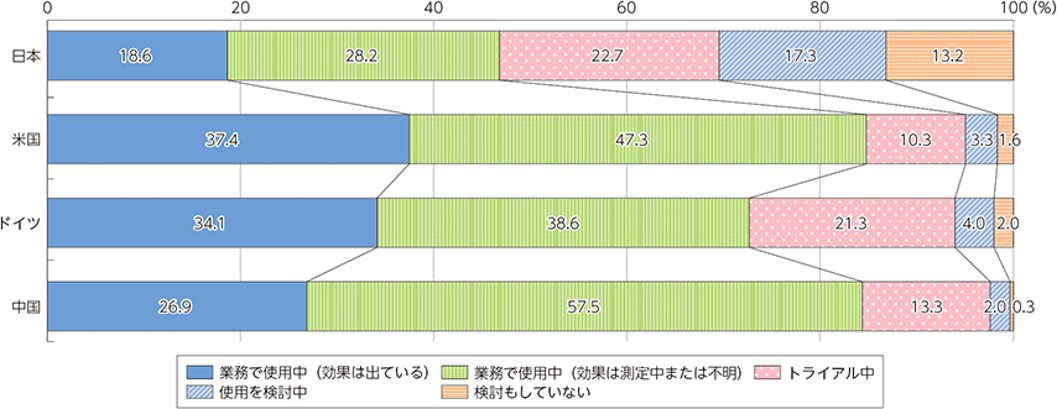

生成AIの企業利用は急速に進んでいます。

総務省が発表している「国内外における最新の情報通信技術の研究開発及びデジタル活用の動向に関する調査研究」レポートによると、日本国内ではトライアルも含め、すでに7割以上の企業がメールや資料作成業務で生成AIを活用しており、他の業務領域でも過半以上の企業が活用を進めています。

また、海外ではその比率がさらに高く、成功事例の波及などに伴い、日本企業もこの勢いに追従していくと考えられます。TDSEにも生成AI活用に関して多くのご相談をいただいており、ここで1つお客様のご支援事例をご紹介します。

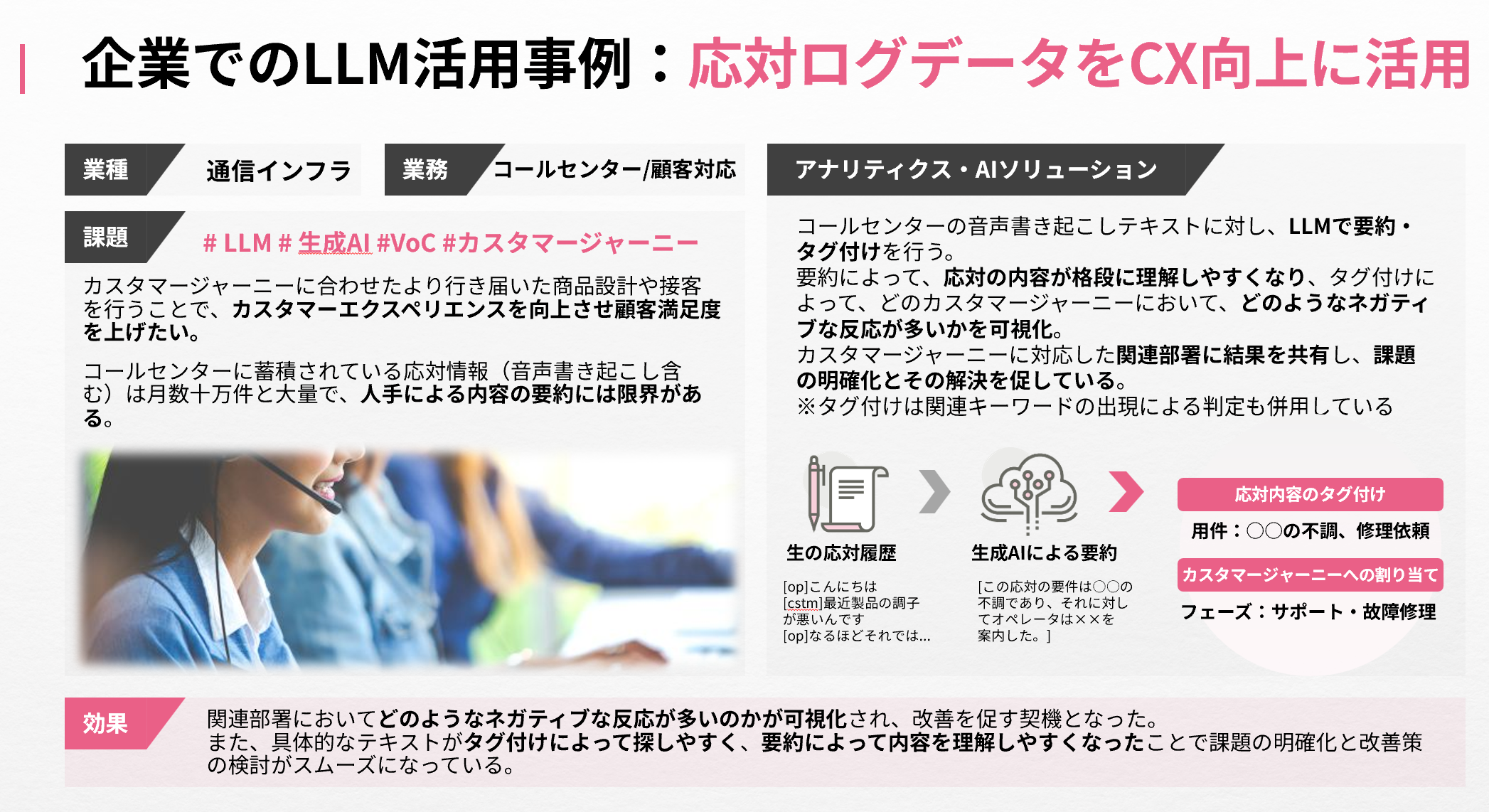

事例:コールセンターの応対ログデータをカスタマーエクスペリエンス向上に活用

コールセンターに蓄積した応対ログ(音声を文字起こししたテキストデータ)データの活用支援事例です。

こちらのお客様は、カスタマージャーニーに合わせた、より行き届いた商品設計や接客を行うことで、カスタマーエクスペリエンスを向上させ、顧客満足度を上げたいという課題をお持ちでした。

しかし、文字起こしした応対ログデータの量は毎月数十万件規模と膨大で、人手ですべてを確認し、内容の要約を行うのはオペレーターの稼働コストや品質のばらつき等、様々な課題があり、困難な状況にありました。

そこで生の応対履歴データをLLMにより要約し、問合せ内容のタグ付けを行いました。

要約により応対内容が格段に理解しやすくなり、タグ付けによってどのカスタマージャーニーにおいて、どのようなネガティブな反応が多いのかが可視化されるため、関連部署に結果を共有し、課題の明確化と改善を促すことが出来るようになりました。

問合せを行ったユーザーの声が迅速にサービス改善につながり、応対業務の効率化と顧客満足度の向上に寄与した事例です。このように、先進的な企業では、生成AI/LLMによってビジネス成果を生み出す活用がされ始めています。

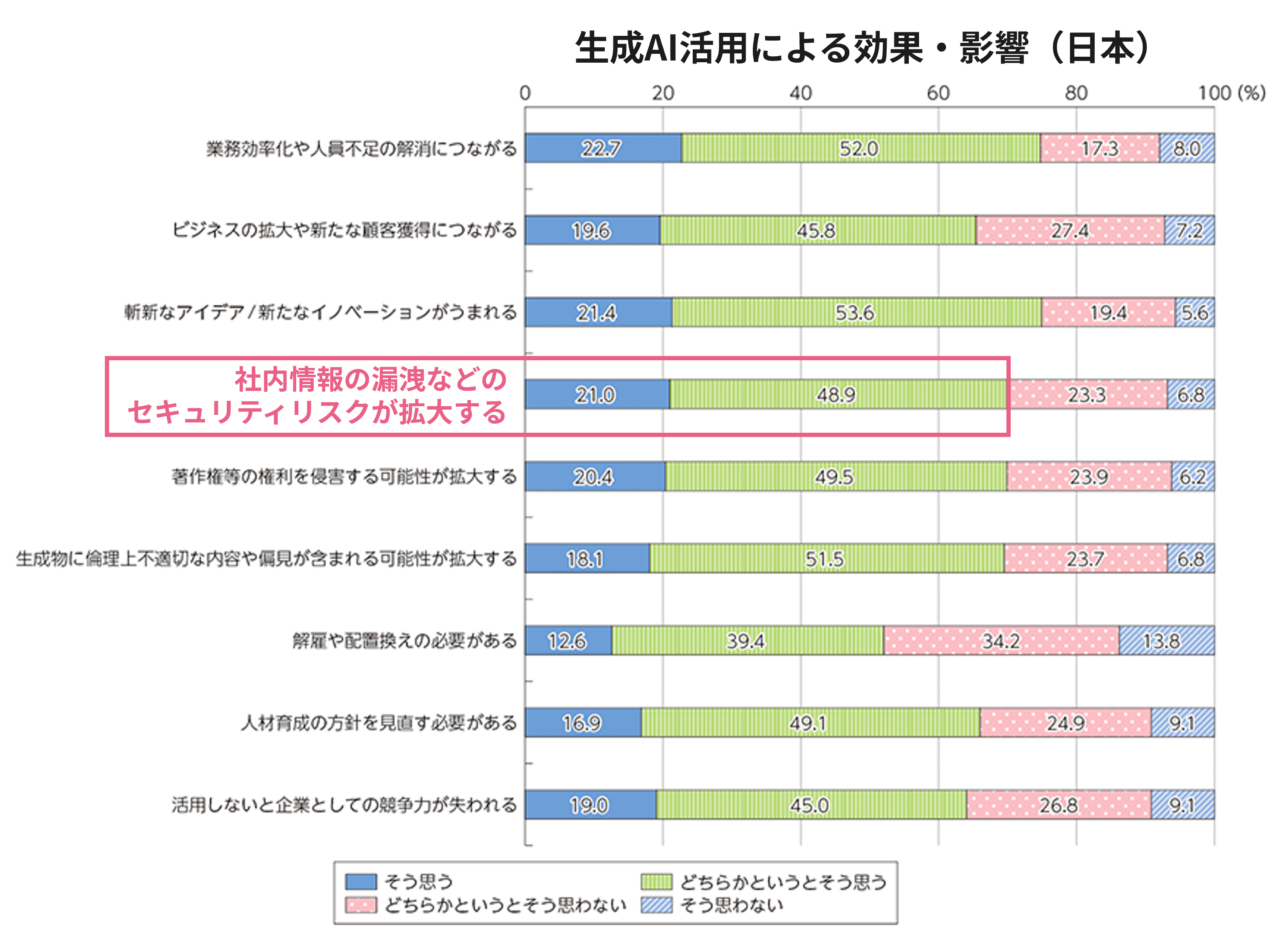

しかしながら、活用が進む一方で、生成AI活用における情報セキュリティリスクへの懸念は依然として高い状態にあるのも事実です。

総務省の「国内外における最新の情報通信技術の研究開発及びデジタル活用の動向に関する調査研究」(2024) では、生成AI活用による効果や影響について聞いた質問の中で、社内情報の漏洩などのセキュリティリスクが拡大するという問いに対して、「そう思う」/「どちらかといえばそう思う」と答えた企業が全体の約70%となっており、特に機密性の高いデータを活用する業務での生成AI活用には慎重な姿勢が見られると考えています。

一方で、生成AI、LLMは急速に進化しています。

LLMは急速な高性能化とコンパクト化が進んでおり、それに伴って業務利用に耐えうる性能を持ったローカルLLM*も出現し台頭してきています。

情報セキュリティへの懸念から生成AI活用に踏み切れない企業にとっては、オンプレミス環境+ローカルLLMが解決策の一つのなりうると考えられます。

ここからはローカルLLMとオンプレミス環境を用いて、セキュアにLLMを活用する方法を解説します。

*ローカルLLMとは:クラウド環境ではなく個別のPCやネットワーク内、オンプレミス環境で実行可能なLLM。従来のLLMはクラウドサーバー上で運用されることが一般的だが、外部ネットワークとの情報通信が発生するため、どうしてもセキュリティ上の懸念が残る。一方でローカルLLMはオフライン環境での実行が可能なため情報セキュリティリスクが軽減され、またネットワーク通信が発生しないことでネットワークの遅延の影響を受けず、リアルタイムな処理が可能といった利点もある。

セキュアな環境での生成AI活用を実現する方法

企業での利用パタ―ン

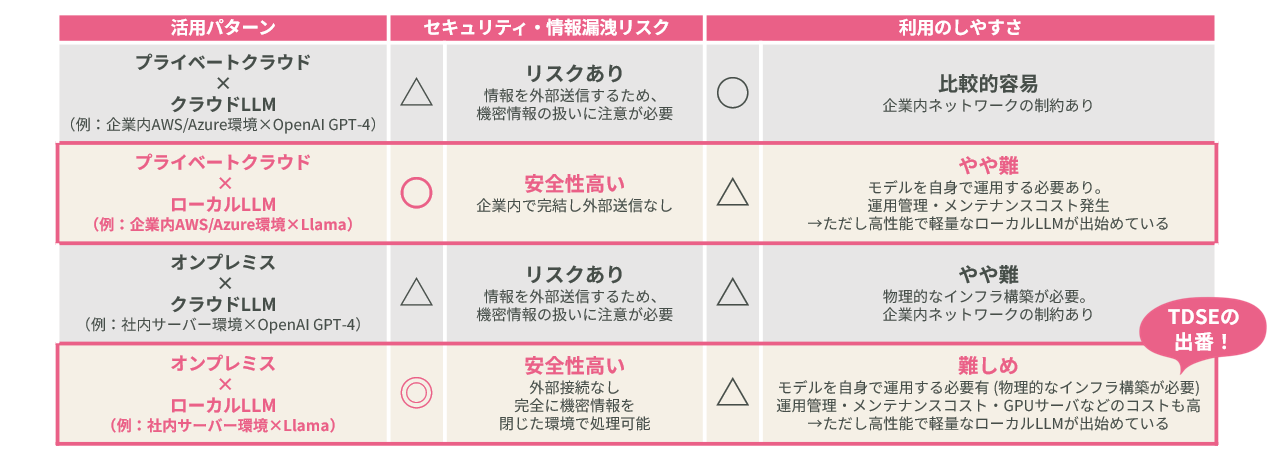

ここでは、企業でのLLMの活用環境について整理してみましょう。

下図をご覧ください。

プライベートクラウドとオンプレミス、クラウドLLMとローカルLLMを組み合わせて4つのパターンをご紹介します。

利用のしやすさとセキュリティ・情報漏洩リスクを比較項目として用意しました。

利用のしやすさで見ると、1つめのプライベートクラウド×クラウドLLMが比較的容易に利用できるパターンですが、一方でセキュリティ・情報漏洩の観点では相対的にリスクが高いと言えます。

セキュリティ観点で最も安全なオンプレミス×ローカルLLMでは、物理的なインフラ構築や運用管理、GPUサーバのコストやメンテナンスのコスト等が発生し、利用には一定のハードルがあると言えますが、ローカルLLMは高性能で軽量なものがどんどん出てきており、特に精度とコストの面での利用のハードルが解消され始めています。オンプレミス環境でのローカルLLM利用が選択肢の一つとして現実的になってきたと言えるでしょう。

ローカルLLM比較

では次にローカルLLMについて、どのようなモデルがあり、どのような性能が出せるのか、という点について解説します。前章でも述べた通り、LLMの進化は目覚ましく、ローカルLLMも十分業務での活用が現実的なものになってきました。

下図をご覧ください。

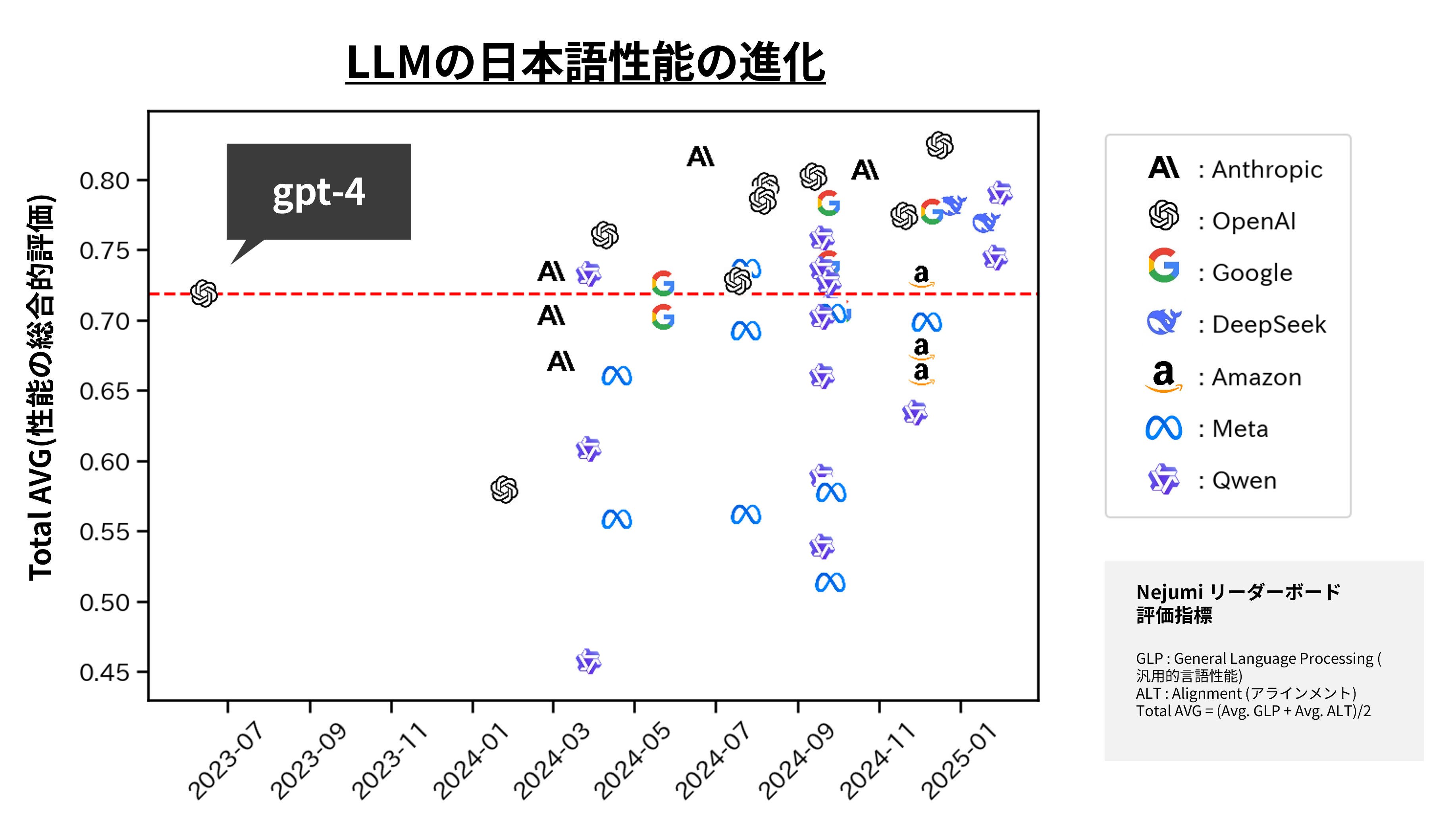

この表は、LLMの日本語性能の進化を表したグラフです(クラウドLLM/ローカルLLMいずれもミックスでプロットしています。)。横軸が発表年、縦軸が日本語データでの性能評価の値を表しています。

Weights & Biases.「Nejumi LLMリーダーボード3 | llm-leaderboard3 – Weights & Biases」. 2/20更新 (参照: 2025/3/3)

Open AIのGPT-4は自然な日本語での対話ができるようになり業務で活用され始めた初期の頃のモデルですが、このGPT-4をベンチマークとしたときに、近年ではGPT-4を超えるような性能のLLMが続々と出てきています。

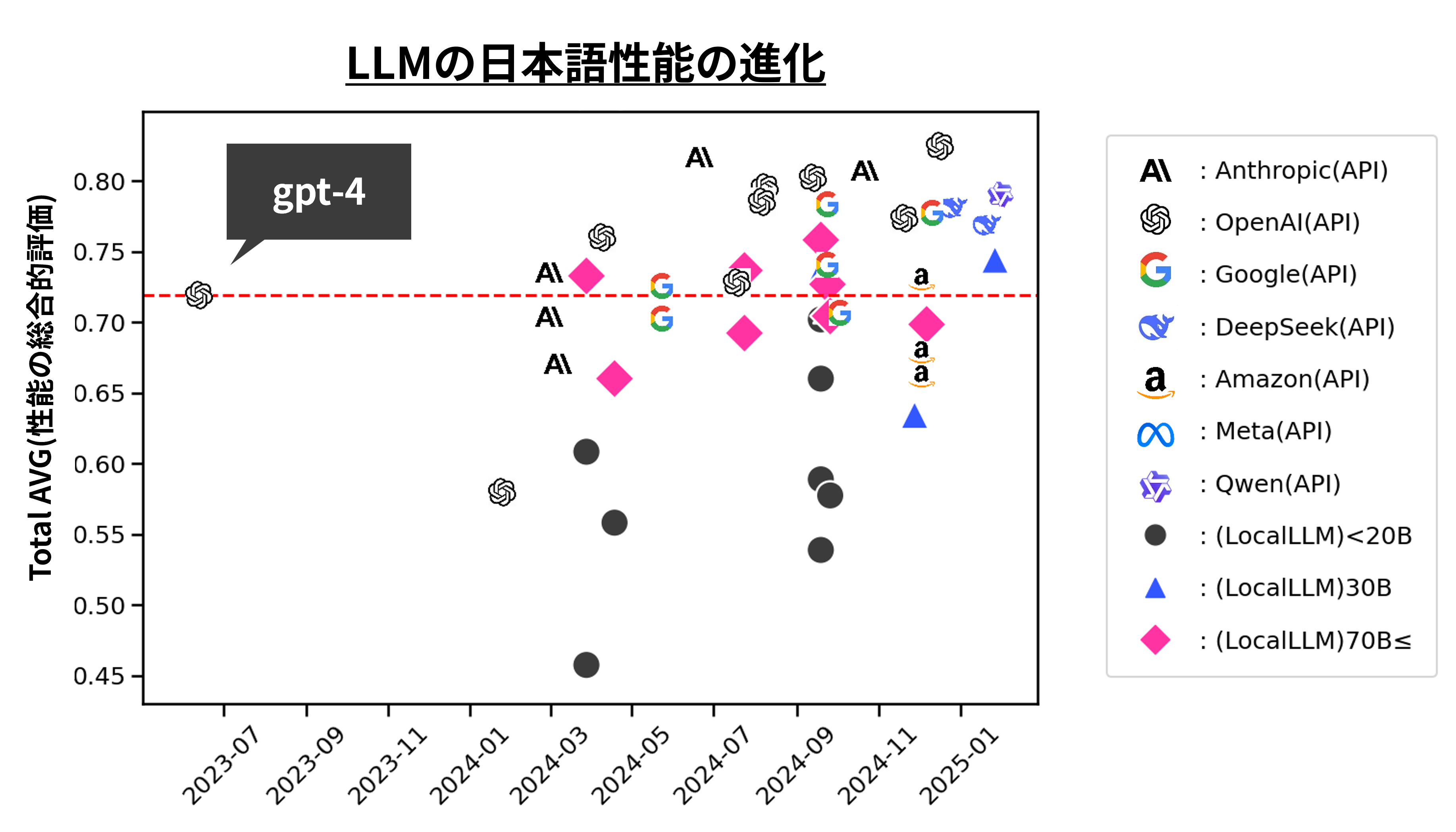

以下の図は、上の図のうち、ローカルLLMを◆、▲、●で表現しています。

◆は、*パラメータ数が70B(700億)以上、▲は30B(300億)、●は20B(200億)以下のローカルLLMを表しています。

Weights & Biases.「Nejumi LLMリーダーボード3 | llm-leaderboard3 – Weights & Biases」. 2/20更新 (参照: 2025/3/3)

この図を見ると、ごく最近では比較的軽量な30B程度のモデルでもGPT-4を超える性能を実現していることがわかります。

*パラメータ数:一般的にパラメータ数はモデルの性能を表す数値として用いられます。このパラメータ数の分だけモデルがトレーニングされており、数字が大きくなればなるほどより複雑なタスクをこなすことができ、モデルの表現力が豊かであると言えます。 しかしながらパラメータ数が大きくなればなるほど、モデルを動かすためのコストも増加するという点では注意が必要で、モデルの性能とコストのバランスを適切に調整する必要があります。

オンプレミス環境でローカルLLMを用いるためのGPUスペック

前述の通り、比較的軽量なモデルで性能が高い(GPT-4同様の性能を持つ)ローカルLLMが出てきていますので、それに伴ってLLMを動かすのに必要なGPUのスペックも小さくなってきています。

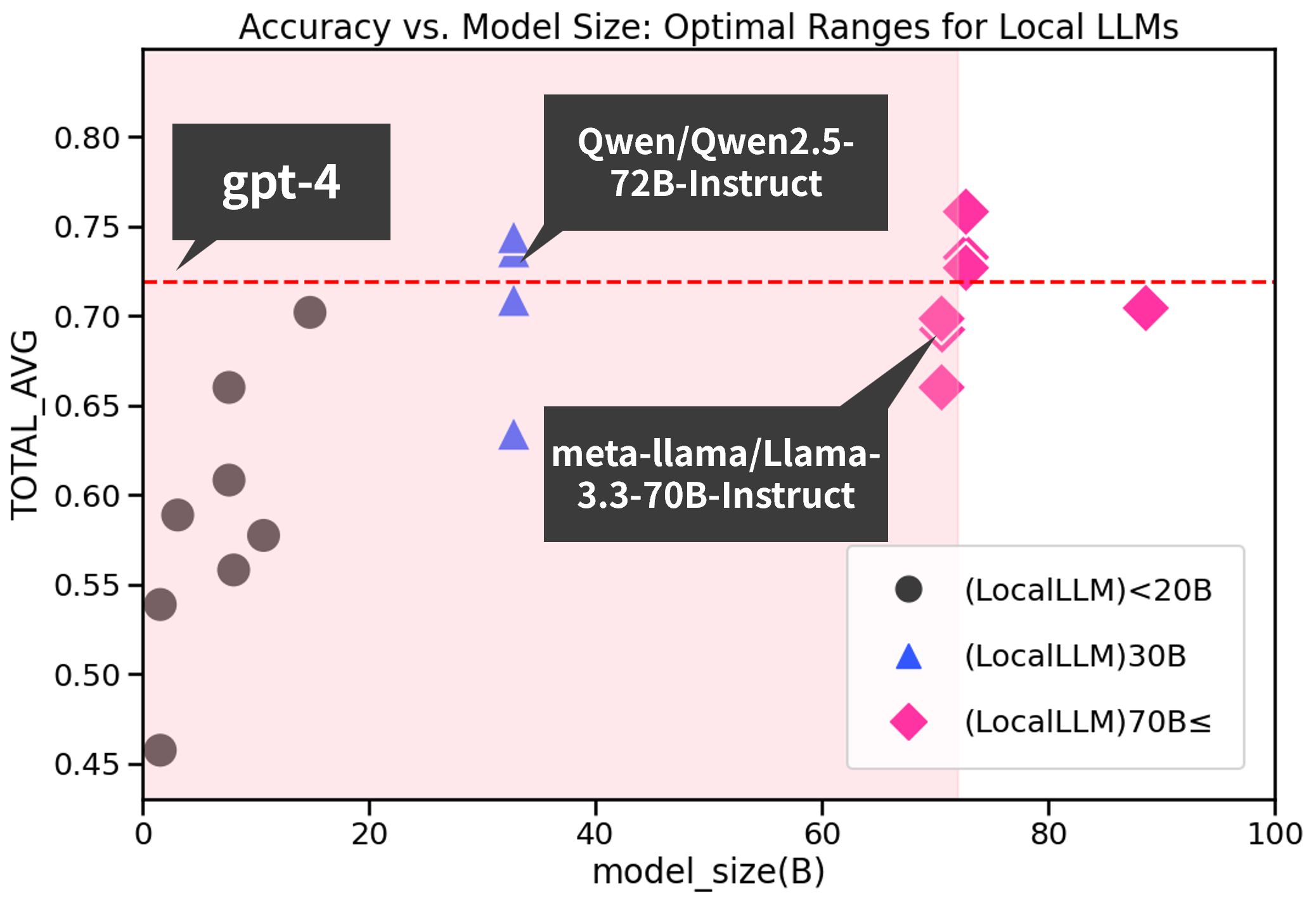

下図は縦軸が日本語性能の総合的な評価、横軸がモデルを表しています。

企業でも導入しやすいモデルとして70B以下のパラメータ数のモデルをピンクのエリアにプロットしています。ベンチマークとしてGPT-4の性能を赤の点線で示しています。

GPT-4の性能に類するモデルとして、パラメータ数70BのLlama-3.3-70Bと、32BのQwen2.5-32Bに注目してみてみましょう。

| Qwen2.5-32B | Llama-3.3-70B | ||

|---|---|---|---|

| パラメータ数 | 32B | 70B | |

| 量子化 | 4bit | 16bit | 4bit |

| CPU | 高性能マルチコアプロセッサ | 高性能マルチコアプロセッサ | |

| RAM | ≧ 32GB | ≧ 64GB | |

| GPU VRAM | ≧ 20GB | ≧ 160GB | ≧ 40GB |

| ストレージ | 100GB | 200GB | |

| 物理サーバーコスト | 200万円~ | 700万円~ | 300万円~ |

30B程度のローカルLLMであれば、20GB程度のGPU VRAMでも動かすことができ、物理サーバのコストとしても200万円~と、コスト面でも運用のハードルも下がってきていることがわかります。

(一方でカスタマーサポートでの利用や自社サービスへの組み込みなど、集中的なアクセスが発生するケースでは物理サーバ負荷分散のための増強が必要ですので、各企業のニーズに合わせた構成についてはご相談ください。)

まとめ

本記事では、データの機密性を保持しながらセキュアにLLMを活用したいといった課題に対して、オンプレミス環境+ローカルLLMがその解決策となりうるということを解説してきました。

とはいえ、オンプレミス環境でローカルLLMを動かすだけでLLM活用プロジェクトがうまくいくわけではありません。

本シリーズではビジネスを強化する生成AI活用のポイントをご紹介していきますので、是非引き続きご覧ください。

▶関連記事:ビジネスを強化する生成AI活用シリーズ②:ローコードツールを用いたローカル環境での生成AIアプリ開発

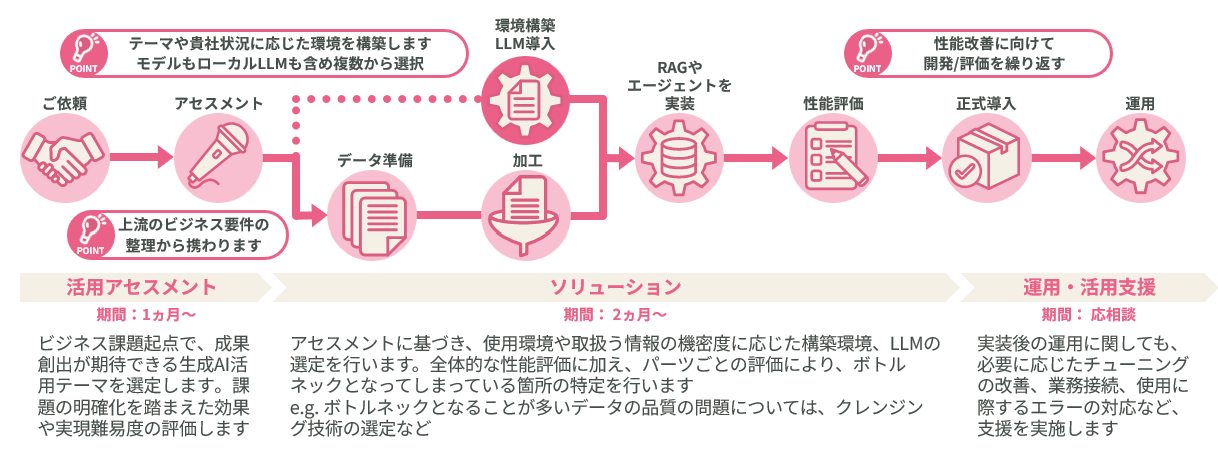

TDSEではLLM活用プロジェクトの豊富なご支援実績から、お客様のニーズに合わせた最適な環境の選定や構築、実装、運用を一気通貫でご支援します。

また、TDSEは、生成AIアプリ開発プラットフォーム「Dify」のオフィシャル販売・開発パートナーです。エンタープライズ版のご提供や各種テクニカルサポートが可能です。

Difyの企業活用をご検討の際は是非TDSEにお気軽にご相談ください。