目次

はじめに

近年、生成AIを活用した業務自動化が急速に進む中で、「チャットUIでのテキスト生成」から、「AIが自ら既存システムを操作する自律実行」へと、その活用範囲は大きく広がりつつあります。

そのカギを握るのが、画面を視覚的に理解し操作する、GUI(Graphical User Interface:コンピュータ操作を視覚的な要素を使って直感的に行えるようにした画面表示形式)エージェントと呼ばれる新しいアプローチです。

TDSEのデータテクノロジーラボでは、GUIエージェントの性能を測る独自のベンチマークを構築し、それを用いて実際にGUIエージェントの検証を実施しました。

本記事ではGUIエージェントが既存のRPAや自動化とどのような違いがあるのかについて簡単に解説し、実施した検証結果やビジネスシーンでの活用の展望についてご紹介します。

▶関連記事:AIエージェントとは: https://www.tdse.jp/blog/aitrend/10593/

GUIエージェントとは ~既存アプリをそのまま自動化する新世代のAI技術

GUIエージェントは、人間と同じようにPCの画面を見て理解し、マウスやキーボードで操作を行う自律型のAIエージェントです。

ユーザーは自然言語で指示を与えるだけで、エージェントが画面上のボタン・入力欄・メニューなどを識別し、目的達成のための一連の操作を計画・実行します。

最大の特徴は、「APIがない古いシステム」や「複雑な社内ツール」を、一切の改修なしに自動化の対象にできる点にあります。

また、同じようにPC作業を自動化する技術としてRPA(Robotic Process Automation)がありますが、RPAが得意とする「事前に定義した固定手順の再生」に比べ、GUIエージェントは以下の特徴を持ちます。

• 柔軟性:画面のラベルや配置が多少変わっても、視覚理解と推論で対応可能。

• 汎用性:APIがないツールやレガシーアプリでも、GUIさえあれば操作対象にできる。

• 自然言語インターフェース:細かな操作手順を記述しなくても、「~してほしい」という意図ベースの指示で動く。

GUIエージェントの性能評価のためのベンチマーク

近年は、商用・研究の双方で多くの GUI エージェントが登場し、その性能を評価するためのベンチマークも併せて整備が進んでいます。

例えばOSWorldは、Ubuntu・Windows・macOS といった実際のOS環境で、Webブラウザやデスクトップアプリ、OSレベルのファイル操作を含む数百のタスクを実行させ、その成功率でエージェントの能力を評価するベンチマークです。

公開当初(2024年)には最新モデルでも10%台の成功率にとどまっていたのに対し、その後は急速に改善が進み、2025年には60%を超える成功率を示すモデルも登場しています(人間の成功率は72%)。

短期間でのこの伸びは、GUIエージェント技術の進歩の速さを象徴しています。

なぜ「独自のベンチマーク」が必要なのか?

先述したOSWorldのような汎用ベンチマークは比較の土台として非常に有用ですが、実務では次のような現場特有の事情が無視できません。

• 社内システムのUIやルール(必須項目・入力規則・承認フロー)

• 部署ごとの運用慣行(例外時のリカバリ手順、通知・再申請の扱い)

• 資料作成・レイアウトの品質基準(社内スライドの体裁・ナレッジの定型化)

• 特定ツールの操作知識(例:Difyのワークフロー構築)

そこでTDSEでは、自社の実タスクに合わせて設計した「独自ベンチマーク」を整備しました。

独自ベンチマークは、次の3カテゴリを軸に全10タスクで構成しています。

例1) 稟議申請/勤怠申請に関する情報を、ローカルファイルから業務アプリに転記する。

例2) 営業用PCの製品仕様書を参照して必要項目(金額・数量等)を抽出し、PC購入の稟議申請フォームの下書きを入力する。

2.資料作成・レイアウト整形タスク(計3タスク)

例1) スライド内の複数の図表について、位置・整列・余白などを調整し、指定フォーマットに沿ったレイアウトへ自動で整える。

例2) 事前に用意されたスライドのタイトル・本文に対応するWeb画面をキャプチャして貼り付け、マニュアル形式にまとめる一連の操作を自動化する。

3.ツール操作・ワークフロー構築をするタスク(計1タスク)

Difyを用いて、指定された条件に合ったワークフローを構築する。(ノード追加、パラメータ設定、テスト実行)

各タスクをGUIエージェントに実行させてその実行結果に応じて得点化し、処理能力を評価します。あらかじめ「正解の状態」(業務アプリの入力済画面や、指定したワークフロー構築済のDify画面など)を人手で作成し、エージェントの作業後の状態との差分に応じて減点します。採点は項目ごとに同じ重みで行い、誤りがなければ満点(1点)、全て誤っていれば0点となるように設定しています。また、作業完了までにかかる時間も重要な要素ではありますが、今回は評価指標には含めていません。

また、業務アプリを扱うタスクでは、実際の社内システムを用いると機密情報や権限設定の都合上制約が大きいため、本検証では実システムの画面構造を模したダミー業務アプリを独自に作成して利用しました。

ベンチマークを用いた検証

独自ベンチマークを用いて、実際のGUIエージェントの性能評価を実施しました。 性能評価の対象としたのは、OSSの Agent S3と、有償のChatGPTエージェントの2つのGUIエージェントです。

Agent S3は2025年10月に発表されたOSSのGUIエージェントで、OSWorldで69.9%の成功率を達成したと報告されています。設計上、画面情報の解釈と行動計画を異なるモデルで役割分担しており、行動計画には汎用LLMを選択可能です。

ChatGPT エージェントは、対応プランで利用できる画面操作の自動化機能で、エージェントモードをオンにするだけでブラウザ操作などを任せることができます。実行はクラウド側の専用環境で行われるため、ユーザーはOSや細かな設定を気にせず利用できるのが特徴です。

Agent S3を用いた検証は、Azure NC24ads_A100_v4上のUbuntuデスクトップ(Xfce)を使用しました。行動計画を担う推論モデルにはGPT-5 (2025-08-07)、画面の認識を行うグラウンディングモデルには ByteDance-Seed/UI-TARS-1.5-7Bを利用しています。公式のAgent S3の実装ではサブタスクの実行回数が15回に設定されていますが、今回の検証ではソースコードを改変して100回としています。

ChatGPT エージェントについては、GPT-5.1を利用しました。実行環境の情報は公開されていません。

ベンチマークの実行結果

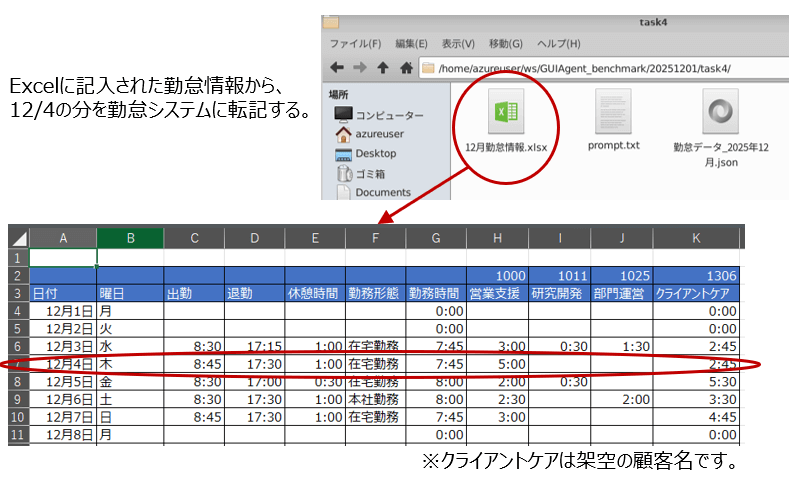

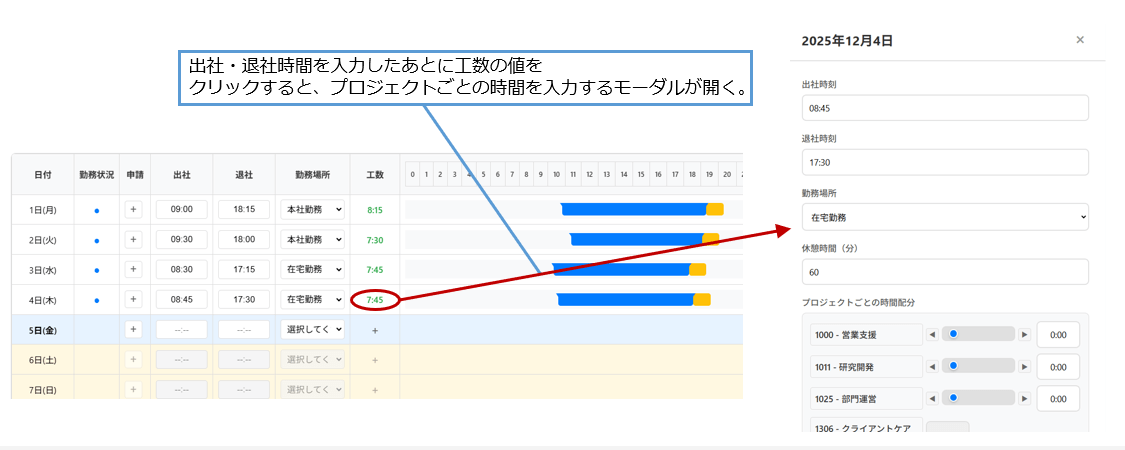

具体的なベンチマークタスクとして、勤怠申請情報の転記をするものについて紹介します。

これは、ローカルPC上のExcelファイルに記入された勤怠情報を、ブラウザ上の勤怠システムに転記するタスクです。ベンチマーク用のダミーの勤怠システムを使って作業を実行しました。

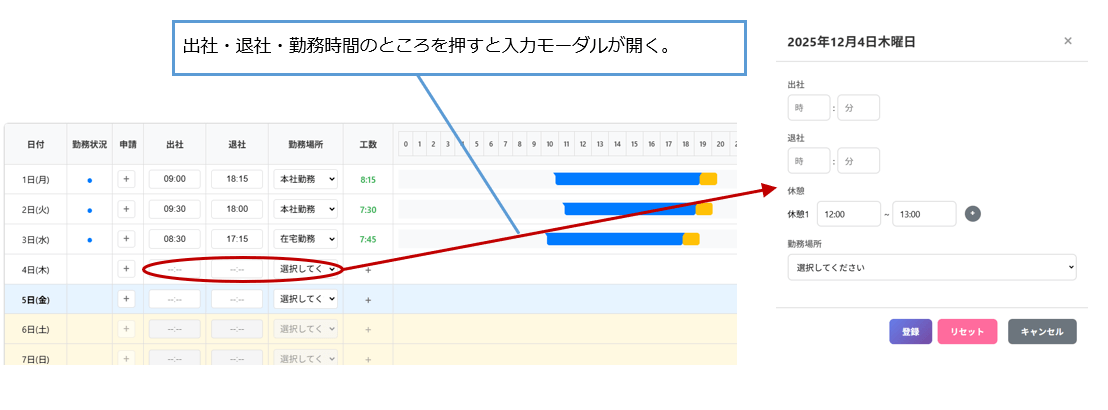

作業開始時点では、勤怠システムが開かれていて、勤怠情報が書かれたExcelファイルの存在も画面上で確認できる状態です。この状態でAgent S3を起動し、12/4の勤怠情報をExcelから勤怠システムに転記するように自然言語で依頼します。エージェントへの依頼文は次の通りです。

この指示内容を完遂するため必要な行動は、次の1-5です。

2. 1.で開いたExcelファイルから12/4の勤怠情報を抽出する。

3. ブラウザ上で開かれた勤怠システムで出社時間・退社時間を入力するモーダルを開き、2.で抽出した情報を適切に入力した後、モーダルを閉じる。

4. 勤怠システムでプロジェクトごとの作業時間を入力するモーダルを開き、2.で抽出した情報を適切に入力した後、モーダルを閉じる。

5. 勤怠システム上にある「保存」ボタンをクリックし、3-4で入力した内容を保存する。

ChatGPTエージェントでも同様の指示で作業を実行しました。ただしAgent S3の時とは異なり、勤怠情報が書かれたExcelファイルはチャットUIで直接アップロードしています。Agent S3と同様、仮想ブラウザ上で勤怠システムが開かれた状態で作業の指示をしています。

作業を実行させた結果、Agent S3・ChatGPTエージェントともに、要求された情報は全て正しく記入されました。一方で作業完遂までに要した時間は、Agent S3では36分、ChatGPT エージェントでは約2分と両者で大きな差がありました。Agent S3では特定の座標をクリックするなどの細かいサブタスクごとにローカルのグラウンディングモデルを用いた推論や、GPT-5のAPIを呼び出す処理が発生することになり、積もり積もって長い処理時間となってしまいました。

全10タスクの実行結果を表1に示しました。

各タスクの実行結果に応じて0~1点の得点を与えています。

Agent S3では10タスク全てを実行しました。

ChatGPT エージェントはブラウザ操作のみで完結する5タスクに限定して実行しました。

両エージェントで共通して実行した5タスクに限定すると、Agent S3は5点中4.3点、ChatGPT エージェントは5点中3.95点と、意外なことにOSSエージェントの方が高い得点となっています。

特にDifyを使ったワークフロー構築タスクでは両エージェントの差が大きく出ており、この点差が合計点に大きく影響しています(ワークフロー構築タスクを除いた4タスクで比較すると、Agent S3が4点中3.75点、ChatGPT エージェントが4点中3.8点です) 。 特に#6 勤怠申請関連タスク2ではAgent S3の得点は0点となっていますが、これは操作ミスで編集対象のエクセルファイルの全項目を削除してしまったためです。

一方、得点には反映されていませんが、作業の実行時間はAgent S3とChatGPT エージェントで大きな差がありました。Agent S3は30分~120分の時間を要していたのに対し、ChatGPT エージェントでは概ね3分以内(ワークフロー構築タスクのみ30分)と、処理スピードではChatGPTエージェントが大きく優れています。

各タスクの得点

| # | タスク | タスク概要 | Agent S3 | ChatGPT エージェント |

|---|---|---|---|---|

| 1 | 稟議申請関連タスク1 | 稟議申請情報をエクセルからシステムに転記する。 | 0.85 | 1 |

| 2 | 稟議申請関連タスク2 | 稟議申請情報をシステムからエクセルに転記する。 | 0.8 | – |

| 3 | 稟議申請関連タスク3 | 購入予定のPC製品仕様書から適切な稟議申請内容を考えて下書きをシステムに入力する。 | 1 | 1 |

| 4 | 経費申請関連タスク | 経費申請情報をエクセルからシステムに転記する。 | 0.9 | 0.8 |

| 5 | 勤怠申請関連タスク1 | 勤怠情報をエクセルからシステムに転記する。 | 1 | 1 |

| 6 | 勤怠申請関連タスク2 | 勤怠情報をシステムからエクセルに転記する。 | 0 | – |

| 7 | スライド作成補助1 | パワーポイント資料に適切な画像を貼付し、レイアウトを調整する。 | 0.5 | – |

| 8 | スライド作成補助2 | パワーポイント資料に貼付済の画像レイアウトを手本のページに合わせて調整する。 | 0.83 | – |

| 9 | スライド作成補助3 | 勤怠システム画面をキャプチャし、パワーポイント資料の適切なページに貼付する。 | 0.9 | – |

| 10 | ワークフロー構築 | Difyを用いて要求されたワークフローを構築する。 | 0.55 | 0.15 |

| 10タスクの合計点 (両エージェントで共通の5タスクの合計点) |

7.33/10 (4.3/5) |

– (3.95/5) |

||

※ChatGPTエージェントではブラウザ操作のみで完結する5タスクのみを実行

表1:全10タスクの実行結果

まとめ

本記事ではGUIエージェントの技術紹介から始まり、独自のベンチマーク構築と2つのGUIエージェントの性能比較の結果を紹介しました。作業の品質はOSSエージェント、ChatGPTエージェントともに高く、人間の作業の補助として活用することを前提に考えれば実用レベルに近い水準になっていると言えます。

しかし、ビジネスでの活用を考える場合には、GUIエージェントを前提とした業務フローの再設計や、自動化によって得られるROIの見極めが不可欠です。

データテクノロジーラボはこうした先端技術の可能性をいち早く見極め、実務への適用をともに探っていくパートナーとして、継続的な検証と実践に取り組んでいます。

ご関心をお持ちの方は、ぜひお気軽にお声がけください。