2024年2月に、OpenAI社が動画生成AIモデル「Sora」を発表し大きな話題になりました。

「これまでの動画生成AIと何が違うの?」「そもそも、SoraってどういうAIなのかわからない」という疑問をお持ちの方も多いのではないでしょうか。

そこで今回は動画生成AI「Sora」について、技術的な部分を踏まえながら、「Sora」の登場が世の中にもたらす影響について解説していきます。

動画生成AI「Sora」とは?

Soraとは、テキストから動画を生成することができるAIであり、複数の被写体や複雑な背景の描写を理解して、最長1分間の高品質な動画を生成することが可能です。 Soraが登場する以前にもテキストや画像から動画を生成するAIは存在しており、例えば、Stability AIの「Stable Video Diffusion」やGoogleの「Lumiere」などがあります。

| Sora | Lumiere | Stable Video Diffusion | |

|---|---|---|---|

| 最大生成時間 | 1分間 | 5秒間 | 5秒間 |

| 解像度 | 1920×1080 自由に変更可 |

1024×1024 固定 |

576×1024 固定 |

| 主な特徴 | ・テキスト/画像/動画から動画生成可能 ・3次元的空間表現可能な動画生成が可能 ・2つの動画を一つに接続できる ・動画の前後の補完ができる ・見切れている物体が映るように補完することができる |

・テキスト/画像/動画から動画生成可能 ・入力画像と同じテイストで動画生成可能 ・対象の物体を指定し表現を変えられる ・欠けている動画箇所の補完 ・静止画の指定した箇所に動きをつけることが可能 |

・テキスト/画像から動画生成可 ・かなりリアルな動画の生成が可能 ・生成時の設定オプションで、フレーム数や繊細な動画を生成することが可能 |

| 一般公開 | × | × | 〇 |

参考文献:

“Stable Video Diffusion: Scaling Latent Video Diffusion Models to Large Datasets” (2023):2311.15127 (arxiv.org)

“Lumiere: A Space-Time Diffusion Model for Video Generation” (2024):2401.12945(arxiv.org)

これらの動画生成AIと比較し、Soraは以下のような特徴を持っています。

- 1. 高画質かつ長時間の動画を生成できる

- 2. 様々な解像度で動画を出力することができる

- 3. 物理的に自然な3次元の空間表現をもつ動画を生成することができる

- 4. 2つの動画を違和感がないようにシームレスに1つの動画に接続する

- 5. 静止画から動画を生成

特に1. ~ 3. については、従来の動画生成技術にはない画期的な特徴といえるでしょう。これらの特徴について解説していきます。

高画質かつ長時間の動画を生成することができる

OpenAI社が公表する情報によれば、「Sora」は、フルHD(1920×1080)の解像度で最長1分間の動画を生成することができます。Soraのフレーム数は公表されていませんが、例えば30fpsのフルHDの動画を60秒間生成した場合、データ量は1980×1020×3(RGB)×30(フレーム毎秒)×60(秒)= 約111億を超える量となり、Soraはこれを生成することができることになります。

対してGoogleの「Lumiere」では、1024×1024の解像度で5秒間の16fpsの動画が生成できます。このデータ量は1024×1024×3(RGB)×16(フレーム毎秒)×5(秒)= 約2.5億となり、比較するとSoraは桁違いなデータ情報を出力して動画を生成することができるということが分かります。

異なる解像度で動画出力することができる

LumiereやStability Video Diffusionなどの動画生成AIモデルでは、一定のサイズのリサイズやトリミングした固定のサイズの動画しか生成することができません。Soraは横1920×縦1080もしくは、横1080×縦1920の範囲内であるならば、自由に解像度を変更して動画を生成することができます。これは、マルチデバイス対応や用途に応じた動画生成の時間などを考えると、非常に汎用性の高い機能といえるでしょう。

物理世界を理解して、3次元的空間表現をもつ動画を生成することができる

また、Soraと他の動画生成AIとの大きな違いは、物理的に自然な表現として生成することができることです。実際に、生成された動画を見ると、人物や物体の動きがスムーズかつ自然な動作で生成されていることが分かります。Soraで生成された車やマウンテンバイクが駆け抜ける動画は、ダイナミックなカメラモーションで撮影された実写映像のように感じられます。

Soraで用いられる技術とは?

Soraの特徴について解説してきましたが、これらの特徴を達成するためにどのような技術が使われているのでしょうか?

OpenAI社がSoraの論文を公開しているわけではありませんが、技術レポートを公開しているので、そのレポートを参考にSoraを構成している技術について、解説していきます。

Soraの技術は、主に次のようにまとめることができます。

- 1. 低次元の潜在空間へ圧縮するネットワーク(Visual Encoder)

- 2. 時空潜在パッチ(spacetime latent patches)

- 3. 動画生成のためのScaling Transformer

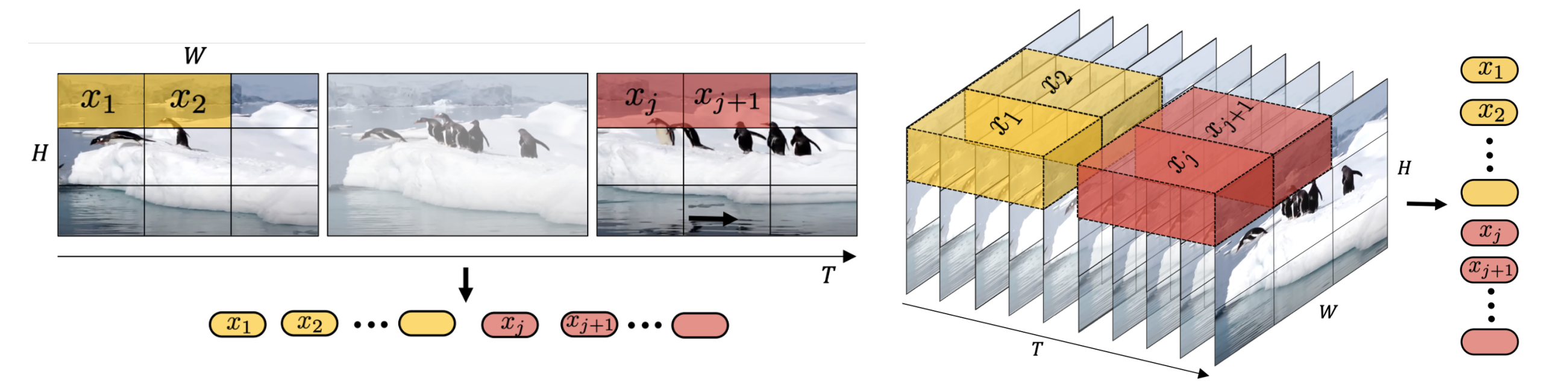

Soraは、大規模言語モデル(Large Language Model)のテキストトークンのように、動画や画像データを「パッチ」という形にすることで、解像度や生成可能時間、アスペクト比が異なる多様な視覚入力情報を効果的に処理することを可能にしています。具体的には、動画をVisual Encoderにより、低次元の潜在空間に圧縮することで動画を「時空潜在パッチ」と呼ばれるパッチに変換しています。(下図参照)

出展元:Video generation models as world simulators | OpenAI

低次元の潜在空間への圧縮するネットワーク(Visual Encoder)

Soraの学習は後述するDiffusion Transformerとは別に、動画を低次元の潜在空間へ圧縮するVisual Encoderと潜在空間から元の空間に戻すDecoderを学習しています。Visual Encoderは、動画や画像の入力データの次元を削減し、時間的及び空間的な潜在表現をもつような特徴を出力することを目的としています。

時空潜在パッチ(Spacetime latent patches)

Visual Encoderより潜在空間に圧縮されたデータから「時空潜在パッチ」と呼ばれるもの作成しています。このパッチによる潜在表現の達成により、Soraはさまざまな解像度や、動画時間の長さ、アスペクト比の動画や画像で学習することができます。OpenAI社はパッチの作成手順については公開していませんが、各要素技術の参考論文を提示しているので、その中身を説明していきます。

まず、パッチ化の方法として、Vision Transformer(ViT)の入力処理が挙げられています。これは、画像を位置に基づいて分割(パッチ化)し、1次元のベクトルに変換(平滑化)する方法です。さらに、これを動画データに対応させた方法が、Video Vision Transformer と呼ばれるモデルで使われています。このモデルで登場する技術では、動画データを3次元的に捉えて、H(パッチの高さ)×W(パッチの横幅)×t(動画のフレーム数)のブロックを抽出して、1次元に圧縮しています。(下図参照)

次に、さまざまな種類の動画を扱えるようにするためには、様々なパッチの数(すなわち、潜在空間の次元数の変動性)に対応する必要があります。その方法として、Patch n’Pack(PNP)と呼ばれる技術が挙げられています。これは、Vision Transformerが入力するシーケンスの長さを変えられる事を利用して、シーケンスをパッキング(自然言語処理のパッキング(packing)とは、異なる長さのシーケンスデータを均一の長さにすることで効率的に処理する手法)することで任意の解像度とアスペクト比の入力画像の処理を行う方法です。これらの技術を使うことで、Soraはさまざまな解像度や長さ、アスペクト比の動画や画像で学習することができ、推論時に生成される動画のサイズを制御することが可能になります。

参考文献:

”An image is worth 16×16 words: Transformers for image recognition at scale” (2020):2010.11929 (arxiv.org)

“Patch n’ Pack: NaViT, a Vision Transformer

for any Aspect Ratio and Resolution” (2023):2307.06304 (arxiv.org)

動画生成のためのScaling Transformer

Soraのモデル構造は、Transformerのアーキテクチャを組み込んだ拡散モデル(Diffusion Transformer; DiT)となっています。拡散モデルとは、元の動画・画像データに無作為にノイズを加えていき、そのノイズを加えたデータに対し、元データを予測するようにノイズ除去するモデルです。

これまでに、言語モデルや画像生成モデルで用いられてきましたが、Soraの登場により動画生成モデルにおいても有用だと発見されました。従来の拡散モデルでは、ノイズ除去のアーキテクチャにU-Netが用いられていますが、Diffusion TransformerではVision Transformerが用いられています。したがって、時空潜在パッチに対してノイズをかけて、一気に学習することで動画を生成することが可能となります。

出展:Video generation models as world simulators | OpenAI

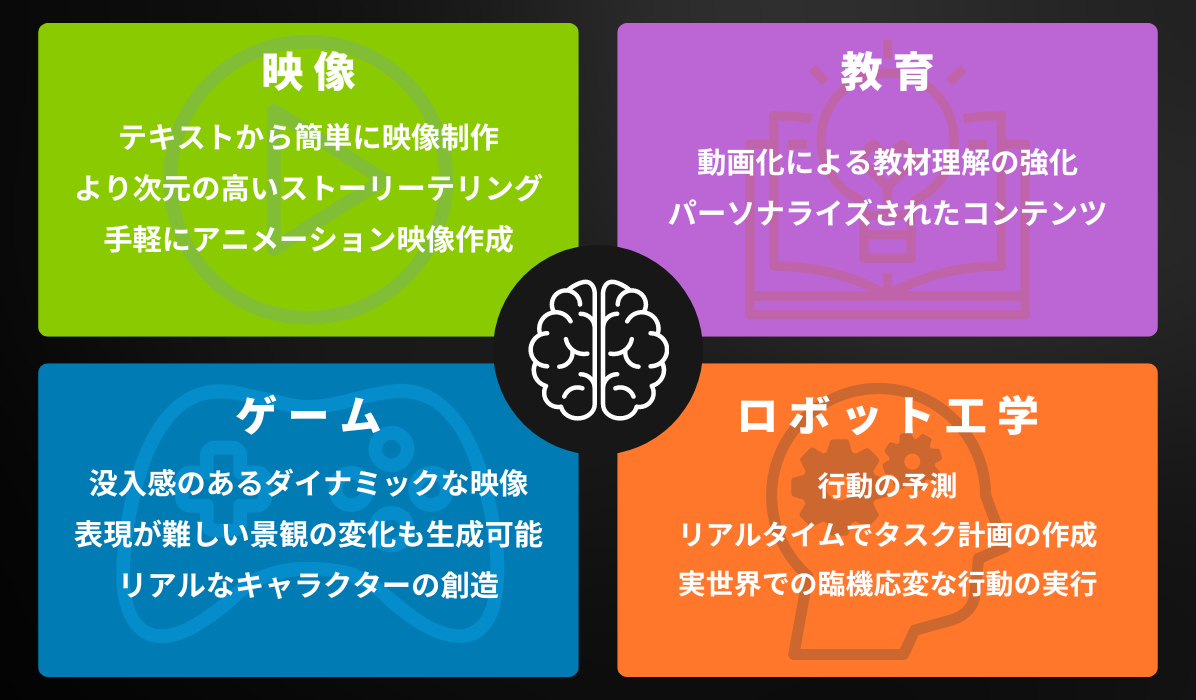

Soraの登場による様々な分野への影響

Soraの登場によりVideo Diffusion Modelが注目され、さまざまな研究分野や業界での導入が急速に加速しています。この技術による影響は、単なる動画生成AIの域を超えて、コンテンツの自動生成から複雑な意思決定プロセスに至るまで、さまざまな分野のタスクに変革をもたらす可能性を秘めています。

教育業界

教育コンテンツは、教師が生徒に一方的な授業(一方通行型授業)の実施やIT化の遅れなどの原因により、未だ大きな変化が見られない状況に陥っており、そのため学生の興味を刺激するものが減り、学習への関心が薄れてしまう可能性があります。これに対し、Video Diffusion Modelは、教育コンテンツに新たな刺激を与える機会を提供できる可能性を持っています。例えば、学生の興味を大幅に刺激する方法として、複雑な科学の現象や歴史的事件などを動画化することで、より実践的な学習体験をすることが可能です。この技術によって、教育コンテンツを学生ごとにパーソナライズされた教育コンテンツに移行することができるかもしれません。

映像業界

従来、映像製作は非常に手間のかかるものであり、多くの場合、数十年の努力に最先端の設備、財政投資が必要となります。特に、3Dのような物理世界のシーンを作成するには、かなりのコストを要します。Soraの登場により、そのようなシーンを単純なテキスト入力のみで高品質、低コストで瞬時に生成できる未来がすぐそこまで来ています。これにより、動画制作のハードルが下がり、クリエイターの創作の幅が広がることが予想され、高度な動画生成技術は、映像製作に革命を与えるものであることがわかります。また、これまで動画制作が難しかった個人や企業も参入しやすくなり、視聴者の好みや流通経路が進化することで、動画がより身近になっていくことでしょう。

ゲーム業界

ゲームコンテンツは、リアルと没入感の限界を常に上げる方法を模索していますが、従来のゲーム開発では、プリレンダリングコンテンツの制作の難易度の高さやスクリプト化されたイベント の制限の複雑さなどが原因により、没入感の高いゲームを制作するのに数年単位の開発期間が必要になることがあります。Soraによる拡散モデルの効果で得られる高品質な動画コンテンツの生成は、短期間で開発者に没入感のある映像など有機的に反応するようなゲーム環境を作成することができるツールを提供できると考えられます。例えば、複雑な気象条件や景観の変化を違和感なく生成するなど、多く時間を費やす制作も低コストで実現することができます。

プリレンダリングコンテンツ:3Dデータを2D画像に変換する工程で、特に事前にレンダリングされたCGのことを言います。3D画像制作でディティールやテクスチャーを加えた後、CPUやGPUを使用して3Dデータを2D画像に表示するよう処理し、それから様々な画面に表示します。ゲームの代表例としては、「Final Fantasy Ⅸ」や「バイオハザードシリーズ」が挙げられる。

スクリプト化されたイベント:スクリプトとは、プログラムが行う一連の処理手順を人間が直感で理解できるような言語で記述したもの。例えば、演出メモ「;※BGM:3番目に設定したメロディを鳴らす」ならば、スクリプト命令文は「[BGM file003 loop=true」のように書く。

ロボット工学

ロボット分野ではマルチモーダルAIの活用が従来から研究されており、Visual Diffusion Modelは、ロボットの”知覚”と”意思決定”を強化するための重要な役割を持っています。Soraの登場により、複雑なビデオシーケンスの生成および理解ができるような段階へと進化し始めています。

例えば、ロボットが複雑な環境下での空間的理解やロボットのより複雑なタスクを高い精度で実行できる未来がそう遠くないかもしれません。2022年10月に「DALL-E-Bot」というシステムが開発されました。

このシステムは、テキストの入力説明に応じて生成した画像を目標に、シーン内の物体を再配置することを可能にしたものであり、モデルにはwebスケールのDiffusionモデルが用いられています。この実現からDiffusionモデルは自律ロボットの理解を強化する可能を示しており、画像や動画データに対応したVisual Diffusion Modelはロボットの視覚と理解をさらに強化する可能性を秘めています。Diffusion Transformerで使用されている潜在拡散モデル(Latent Diffusion)は、2024年1月に言語指示による動画予測モデル「Seer」で用いられており、動画形式での行動結果を予測することでロボットがタスクを理解して実行することが実現されています。

また、環境の理解に関しては、2023年12月にロボット学習タスクのために実世界の多様なデータを画像やテキスト生成モデルを活用して、リアルなデータを生成することで、データセットの多様性や量を増やすことができるシステム「GenAug」があります。これにVisual Diffusion Modelを対応させることで、実世界のデータ量が増加し複雑な環境でも学習することが可能となるでしょう。

参考文献:

“DALL-E-Bot: Introducing Web-Scale Diffusion Models to Robotics ”(2023):2210.02438 (arxiv.org)

“Seer: Language Instructed Video Prediction with Latent Diffusion Models”(2024):2303.14897 (arxiv.org)

“GenAug: Data Augmentation for Finetuning Text Generators”(2020):2010.01794 (arxiv.org)

出展元:(ITmedia):画像生成AIが“ロボットの動き”を生成 英ICL「DALL-E-Bot」開発 – ITmedia NEWS

Soraの課題

物理法則の完全な理解はまだ先

Soraが物理世界を理解し始めたことは大きな進歩ですが、物理法則を完全に再現するにはまだ難しい課題が残っています。例えば、椅子は「硬いもの」と人間は分かりますが、Soraはそれをモデル化できず、現実的に不可解な挙動をしている動画が生成されてしまいます。また、ガラスが粉々に砕けるシーンのような、物体間の複雑な相互作用を正確に表現することも現状できていません。このように、Soraの物理世界の理解には限界があり、完全に実現するには、さらなる技術の進歩や物理世界のデータが必要不可欠です。

安全性の確保

Open AI社はSoraの一般公開の具体的なリリース日を設定しておらず、悪用されないような安全策とAIによる倫理的リスクへの対策を慎重に進めていると技術レポートで公表しています。対策としては、Soraによって生成された動画に”AIによる生成”であることが分かるようなメタデータを付与することを検討しています。これにより、ディープフェイクやデマを招くコンテンツの拡散を防ぐことができます。また、使用ポリシーに違反するコンテンツ生成を防ぐため、事前に入力するプロンプトをチェックして除外するフィルターも用意しているとされています。

まとめ

Soraは動画生成AIの一つの到達点ですが、OpenAI社はこのAIを「AGI(汎用人工知能)実現への重要な通過点」と位置付けています。ロボット工学分野で述べたように、現実世界のデータを十分に取得することで、物理世界のシミュレーションの精度が向上し、より人間に近い汎用的な動作を実現できる可能性があります。今後のSoraの進化が、AGI実現に向けた重要な基盤となることには違いないでしょう。

TDSEは、これまで画像処理や自然言語処理等、多種多様なモーダルを用いたデータ活用プロジェクトをご支援してまいりました。 LLMのビジネス活用に関するプロジェクト実績もございます!

LLMやマルチモーダルAIのビジネス活用にご興味をおもちでしたら、是非お気軽にご相談ください!

TDSEの専門チームがお客様の具体的なニーズに合わせたソリューションをご提案いたします。