目次

マルチモーダルAIとは?

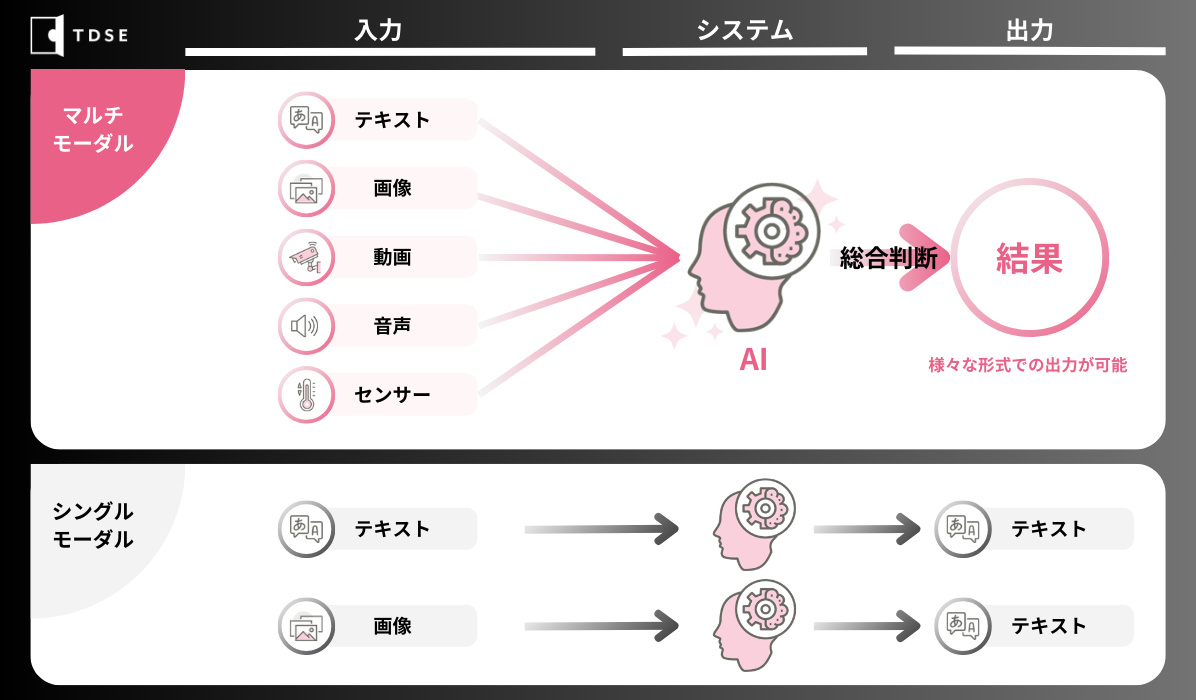

マルチモーダルとは異なる種類のデータ(テキストや画像、音声、動画、センサー情報など)を組み合わせたり、お互いに関連付けたりして処理することを指します。

マルチモーダルAIが注目されている点としては、異なる種類のデータの情報を組み合わせることで、より豊かで深い理解を可能にすることです。

例えば、画像と音声データを組み合わせて、ビデオ内の特定のシーンを理解することができます。また、テキストデータとセンサーデータを組み合わせて、特定の環境下での活動を分析することも可能です。

このように、マルチモーダルAIは、シングルモーダルよりも精度の高い情報を出力でき複雑な問題に対応することができます。

マルチモーダルAIの原理

マルチモーダルAIは、画像や音声など、各モダリティのデータの特徴量を抽出(エンコード)して、共通の潜在特徴空間へマッピングします。これにより、異なるモダリティ間での特徴量の演算が可能となります。

その後、マッピングした特徴量とテキストの特徴量をLLMに知識として与えていき、LLMによって演算された特徴量を変換(デコード)することで、各モダリティにあった形式を得ることができます。

マルチモーダルAIの学習手順

学習の方法としては、事前学習(Pre-Training)とInstruction-Tuningの2段階に分けられます。

①事前学習(Pre-Training)

事前学習の対象となるのは、LLMとテキスト以外のデータを抽出・生成するのに使用するモダリティです。

LLMや各モダリティのパラメータは凍結(更新しないように)して、共通の潜在特徴空間へのマッピングが最適になるようにパラメータを更新していきます。

このとき事前学習で使われるデータセットは、テキストデータと画像などの異なるモダリティのデータの組になります。

事前学習を行うことで、マルチモーダルAIは自然な文章を生成することができるようになりますが、生成する文章の制御の難しさも問題として内在しています。特に、暴力的・差別的な文章が生成される可能性があるため、一般的な利用を妨げる要因になっていました。

そこで、2つ目のInstruction-Tuningをすることで、この問題を克服しています。

②Instruction-Tuning

Instruction-Tuningは、マルチモーダルAIのパラメータを微調整する方法のことで、主に、教師あり学習によるFine-Tuning(Supervised Fine-Tuning, SFT)と人のフィードバックを利用したFine-Tuningがあります。SFTは命令対応形式で行われ、例えば、ある画像とその画像に対する質問、それに対する答えをモデルに学習させます。これにより、より適切な回答を生成するように調整することができます。

SFTの後に、人のフィードバックを利用したFine-Tuningを行い、モデルの回答を微調整していきます。

この時に利用されるのが、RLHF(Reinforcement Learning from Human)と呼ばれる強化学習の手法です。

これは、報酬と呼ばれる間接的な目的関数を参照することでモデルを学習していきます。

具体的には、手動もしくは自動でプロンプトを入力し、文章を生成させ、人がそれを好ましい順にランク付けをし、そのランクを予測するように学習していきます。

マルチモーダルの活用技術と事例

Visual Question Answering (VQA)

VQAとは?

VQAとは、画像と言語という2つのモダリティを使ったマルチモーダルに関する研究分野で、ある画像とその画像に対する質問文が与えられたときに、適切な答えを導き出す問題です。

VQAの分野で良い結果を残しているモデルの一つとして、OpenAI社が開発したGPT-4Vが挙げられます。

GPT-4Vは言語をはじめとして画像、音声を同時に扱うことができるマルチモーダルモデルで、このモデルは一般的に入手可能なインターネット上の膨大なテキストや画像データを基にして文書中の次の単語を予測するように学習されており、よりユーザーの意図に沿う回答を導かせるためにRLHFによって微調整されています。

VQAのビジネス活用例:生産現場におけるヒヤリハット要因の検知(株式会社東芝)

近年、労働災害による負傷者(休業4日以上)は増加傾向にあり、人手不足が常態化している中で生産現場の安全性の確保は喫緊の課題となっています。

そこで同社は画像に関する質問に対して高精度で回答できる質問応答AIを開発しました。

この手法では人や物のみならず、床や通路などの背景や空間領域を認識することができます。

これにより「通路に物が置いてあるか」「人物が所定の位置に立っているか」などの質問をAIが理解できるようになりました。

マルチモーダルDXの活用によって、画像と質問を変えることで現場に応じたモニタリングが可能になりました。

Action Recognition (行動認識)

Action Recognitionとは?

Action Recognitionとは、画像(映像)と音声という2つのモダリティを組み合わせた行動の認識に関する研究分野です。Action RecognitionはシングルモーダルAIでは判断が難しい状況に対して、より高度な判断を可能にします。

Action Recognitionはさまざまな分野で応用されており、例えばヘルスケアでは患者の日常生活の行動を監視し、異常な行動を検出することで早期に健康問題を識別することができます。

Action Recognitionのビジネス活用例:画像と音声を組み合わせた迷惑行為検出(NTTデータ)

従来のシングルモーダルなAIでは、防犯カメラの映像を使って迷惑行為を検出しようとしたときに人の「動き」による迷惑行為だけしか検出することができませんでした。そこで同社は防犯カメラの映像に騒音計の音量データを加えたマルチモーダルAIを開発しました。

これにより映像だけでは判断できなかった、屯たむろして騒ぐといった「騒音を伴う迷惑行為」なども検出することができるようになりました。

MultiModal Retrieval Augmented Generation(MM-RAG)

MM-RAG(マルチモーダルRAG)とは?

MM-RAGとは、テキストや画像を扱うことができる検索拡張生成(RAG)のことで、LLMの拡張技術のことを言います。

LLMは、他言語への翻訳やプロンプトに基づく文章の生成や質問回答などができますが、課題もあります。

一つ目は、新しい情報や時事的な情報に対応することができないことで、二つ目は、学習データにない(誤った)回答を返してしまう「ハルシネーション(Hallucination:幻覚)」を起こしてしまうことです。

RAGは、これらの問題への対策として知られています。

RAGは、社内資料など、データベースに補完した独自の知識をモデルに与えることで固有の回答を生成する仕組みです。

ユーザーがプロンプトを出すと、LLMの内部にある知識から類似したドキュメントを探し出し、プロンプトと組み合わせることで、より精度の高い回答が生成されます。マルチモーダルRAGは、Visual Question Answering(VQA)のように、ある画像とその画像に対する質問が与えられた際に適切な答えを出す他に、画像や図表なども含めて答えてくれることが可能になります。

本記事では、マルチモーダルAIの原理やマルチモーダルLLMをはじめとした様々な活用技術、事例について簡単に解説してきました。

ビジネスシーンでのマルチモーダルAI活用の需要はこれからさらに高まっていくでしょう。

TDSEはこれまで画像処理や自然言語処理(NLP)等、多種多様なモダリティを用いたデータ活用プロジェクトのご支援をして参りました。

これらの実績を基にした知見は、これからのマルチモーダル時代においてはより一層重要な役割を果たしていくと考えています。

もしご興味をお持ちでしたら、ぜひお気軽にご相談、お問い合わせください!

TDSEの専門チームが、お客様の具体的なニーズに合わせたソリューションをご提案いたします。