目次

マルチモーダルAIとは?

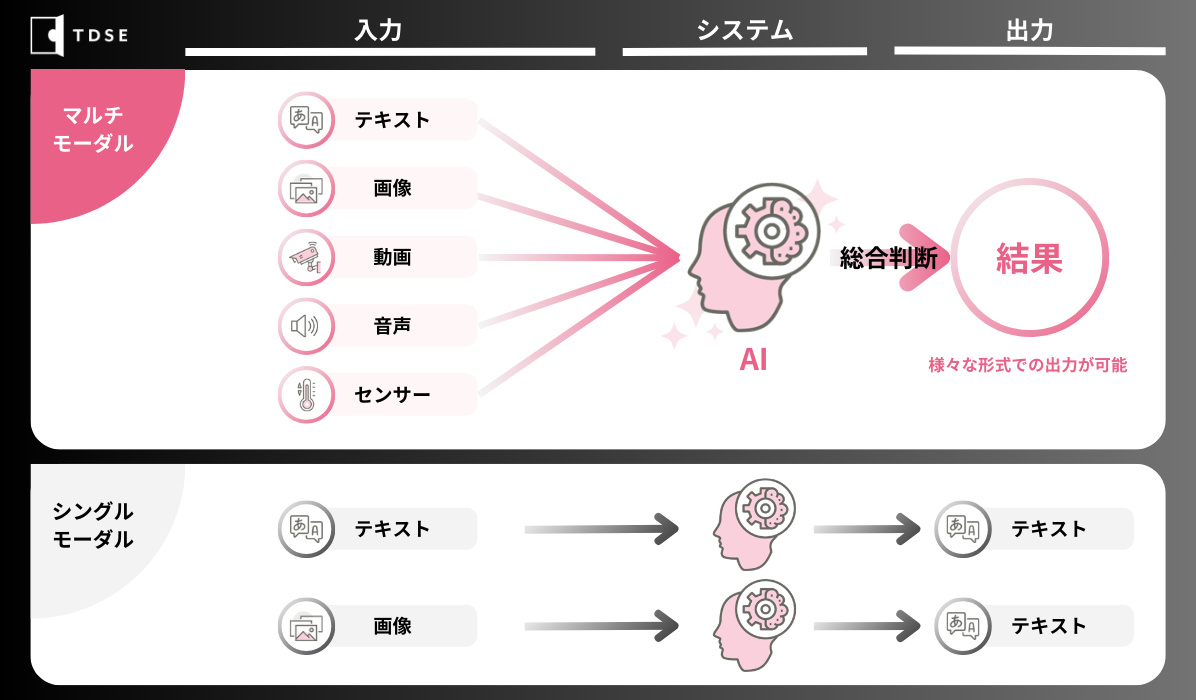

マルチモーダルとは異なる種類のデータ(テキストや画像、音声、動画、センサー情報など)を組み合わせたり、お互いに関連付けたりして処理することを指します。

マルチモーダルAIが注目されている点としては、異なる種類のデータの情報を組み合わせることで、より豊かで深い理解を可能にすることです。

例えば、画像と音声データを組み合わせて、ビデオ内の特定のシーンを理解することができます。また、テキストデータとセンサーデータを組み合わせて、特定の環境下での活動を分析することも可能です。

このように、マルチモーダルDXは、シングルモーダルよりも精度の高い情報を出力でき複雑な問題に対応することができます。

マルチモーダルAIの技術動向

マルチモーダルAIの歴史

マルチモーダルAIの研究は、1980年半ばから始まりました。

この時期は、音声認識や画像認識などのシングルモーダルに焦点を当てた研究が主流でしたが、複数のモダリティを統合することの重要性が認識され始めました。

例えば、音声と画像を組み合わせることで音声認識の精度を向上させる研究が行われていました。

その後、ディープラーニングの登場によって、マルチモーダルAIの研究が急速に進み始めました。

2013年には、テキストと人間の表情画像をもとに、アバターが内容に合った表情でテキストを読み上げる「Expressive Visual Text-To-Speech」という研究が登場しました。

そして近年になってChatGPTなどの自然言語処理技術を使った大規模言語モデルの注目度がますます高まっていまり、2023年には、GPT-4VやGemini、2024年ではSoraといったマルチモーダルモデルの発展につながっています。

マルチモーダルAIと大規模言語モデルとの親和性

マルチモーダルAIの発展により、大規模言語モデル(LLM : Large Language Models)の研究は大きく進歩しました。

LLMは、大量のテキストデータとディープラーニング(深層学習)技術によって構築されたモデルであり、ユーザーがプロンプト(prompt:大規模言語モデルに対する命令)を出すことで、対話的に動作します。

LLMの入力データはテキストデータのみでしたが、マルチモーダルAIの登場により、画像や動画、音声データも同時に入力することで、より精度の高い文章の生成だけではなく、画像や音声の生成といった、異なるモダリティ間の変換を可能にしました。

このような複数のモダリティを扱うことができるLLMのことをマルチモーダルLLM(MM-LLM)と呼びます。

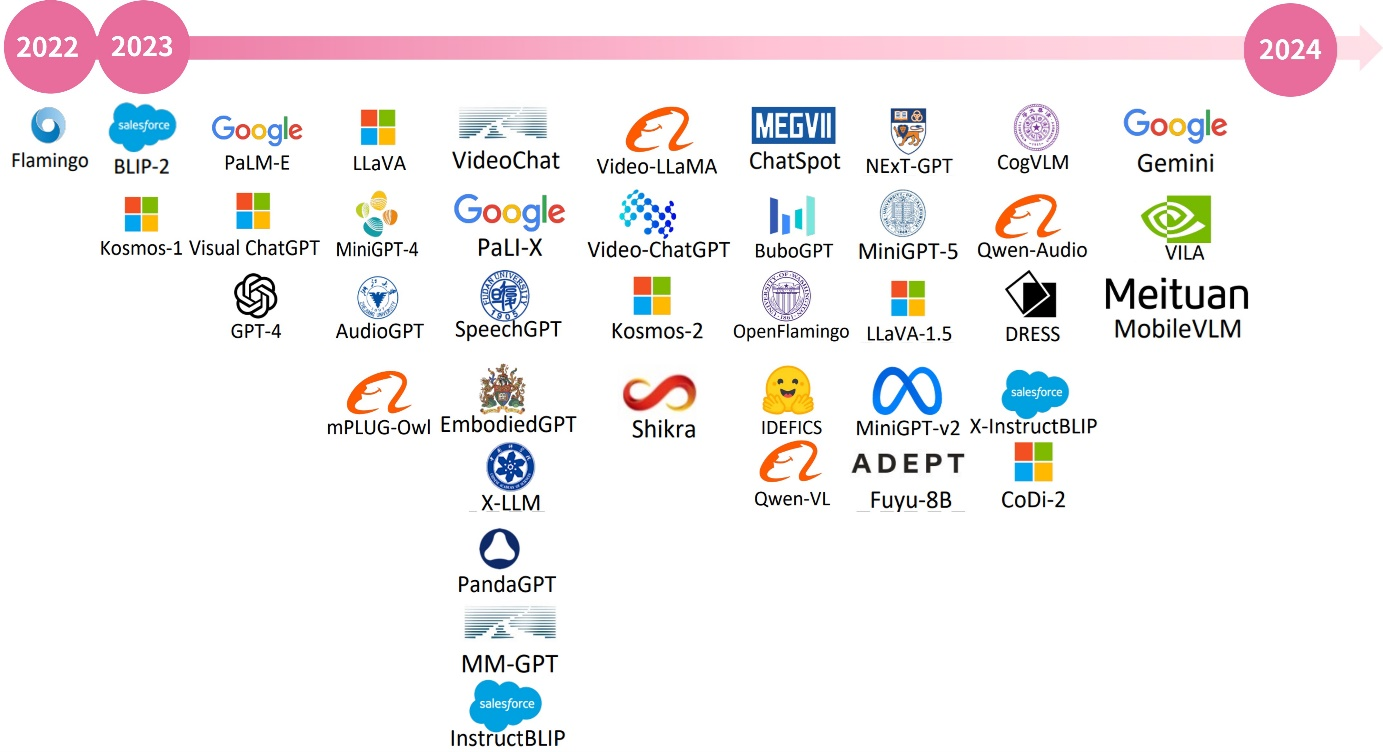

2022年のFlamingoの登場から1年ほどで数多くのモデルが登場し、その後、GPT-4VやGeminiの登場によって、マルチモーダルLLMの研究が注目され、今、最もホットな分野になっています。

「MM-LLMs: Recent Advances in MultiModal Large Language Models」(2024), 2401.13601.pdf (arxiv.org)

マルチモーダルLLMの初期研究は、Flamingoを始め、BLIP-2、Kosmos-1, LLaVAなどがあります。

これらは画像とテキストデータを使って学習を行うことで、精度が高いテキスト生成を行うことが可能です。

これらのモデル登場後、出力に対しても、テキスト以外のモダリティ(画像や音声)を生成するマルチモーダルLLMが登場してきました。

例えば、OpenAI社が発表したMiniGPT-5は、画像とテキストデータの情報を使ってテキストの他に画像データも生成することができます。

SpeechGPTでは、指示や質問、回答などの音声とそのテキストデータを使って、音声の生成を行うことができます。

最近の研究の取り組みでは、任意のモダリティの入出力を扱う「Any-to-Any」が注目されており、より汎用的なAIの開発が行われています。

OpenAI社のVisual ChatGPTは、ChatGPTとVisual Foundation Models(VFMs)2を組み合わせて使用することで、テキストのみから画像を対話的に生成したり、説明させたりすることができます。

2024年2月にはOpenAI社からテキストから動画を生成することができるSora3が登場しました。

従来の動画生成AIは決められた解像度や短い動画の生成しか行うことができませんでしたが、Soraは、動画の解像度やアスペクト比を自由に指定して動画を生成することができ、最大1分間の動画を生成することが可能です。

他にも、2つの動画をシームレスに1つの動画に生成することや、3次元空間表現が可能なダイナミックなカメラワークをする動画に生成することもできます。

さらに画像もプロンプトに入れることができ、画像に対してアニメーションを付けたりすることも可能です。 このように、マルチモーダルLLMは、汎用人工知能(AGI)4の重要な一歩として、関心を集めています。

2. 視覚基盤モデル(Visual Foundation Models)は、大量かつ多様なデータで事前学習され、多岐にわたるタスクに適応可能な機械学習モデルの一種。

3.OpenAI(2024)

4.汎用人工知能(AGI)とは、人間の持つ、様々な問題に対して柔軟に対処することができるAIのこと。OpenAI社が発表したGPT-4がその第一歩と言われている。

マルチモーダルAIの最新技術の台頭

最も注目を集めたマルチモーダルAIに、OpenAI社が2023年9月にChatGPTに画像認識などのマルチモーダル機能を追加した「GPT-4V(GPT-4 with Vision)」と、Googleが2023年12月に次世代AIモデル「Gemini」があります。

GPT-4Vとは

GPT-4VはOpenAIによって開発されたもので、既存のGPT-4モデルを基に、さらに進化した形態をとっています。GPT-4Vは、特にマルチモーダルとしての能力に焦点を当てており、これまでのテキストベースの処理から一歩進んで、画像や音声などの複数のモーダルを統合的に扱えるようになりました。

特徴① 画像解析

GPT-4Vの特徴の一つは、その画像解析能力にあります。従来のモデルではテキスト情報のみを処理していましたが、GPT-4Vは画像データを直接入力として受け取り、その内容を理解し、関連する質問に答えることが可能です。例えば、ユーザーが旅行中に撮影した風景写真をアップロードすると、GPT-4Vはその画像を分析し、その場所に関する情報や歴史的背景などを説明できます。

特長② 音声出力

GPT-4Vは音声出力機能も備えています。これによりテキストだけでなく、音声対話も可能になり、より自然で直感的なユーザーインターフェースを実現しています。音声出力機能を通じて、GPT-4Vは質問に対して音声で回答できます。

Geminiとは

Geminiとは、Googleが2023年12月に発表したマルチモーダルAIモデルです。このモデルは、従来のテキストベースのAIモデルを大きく進化させ、画像、動画、音声など多様なデータ形式を理解し、処理する能力を持っています。

特長① モデルサイズ

Geminiは3つの異なるモデルサイズを提供しています。

最大のモデルであるGemini Ultraは、非常に複雑なタスクに対して最高のパフォーマンスを発揮します。

中規模のモデルであるGemini Proは、パフォーマンスとコスト、応答時間のバランスを最適化しています。

最も小さなモデルであるGemini Nanoは、省電力を重視したデバイス上での実行に適しています。

このように、Geminiは大規模なデータセンターからスマートフォンのようなモバイルデバイスまで、幅広いプラットフォームでの利用を想定して設計されています。

| モデル | 概要 |

|---|---|

| Gemini Ultra | 非常に複雑なタスクに対応する、高性能かつ最大のモデル |

| Gemini Pro | 幅広いタスクに対応する最良のモデル |

| Gemini Nano | デバイス上のタスクに最も効率的なモデル |

特長② ベンチマークにおける卓越した性能

2023年12月に公開された複数のベンチマークテストで、Geminiがその優位性を表しました。

Gemini Ultraは、32種類のベンチマークテストのうち、30種類で既存の最高水準を上回る結果を記録しました。

特にMMLU(数学や法律など57科目において、一連のテキスト試験を通して知識と問題解決能力をテストするベンチマーク)では90%のスコアを達成し、各分野の人間の専門家を上回るパフォーマンスを発揮しています。

また、MMMU(様々な種類の入力によるマルチモーダルタスクを測るベンチマーク)でも59.4%というスコアを記録し、Geminiがテキスト以外の入力に対してより複雑な推論能力を発揮する初期徴候を示したと発表されています。

マルチモーダルAIの今後の技術動向

マルチモーダルAIが今後、さらに進化していくためには、いくつかの方向性があると考えられます。

より強力なモデルの開発

マルチモーダルAIは、現在までに様々なモダリティ(画像や動画、音声、3Dセンサー)を扱うことができますが、今後、Webページや図表などのデータに対応できるようにすることで、さらなるモデルの向上が見込めます。

また、さまざまなモダリティとサイズの異なるLLMのバリエーションが増え、それらを組み合わせることが可能になると、特定の要件に基づいた、より柔軟性の高いモデルを作成することができます。モデルの品質向上においては、学習のデータセットの改善および拡張も重要です。

ユーザーが出すプロンプトを多様化することで、ユーザーコマンドを実施する際やモデルが理解する際の効率の向上が見込まれます。

より強力なモデルを維持・継続していくにあたっては、モデルに対して常に新鮮な情報を与えることも必要です。

実際のアプリケーションとして使用するためには、追加機能をサポートするために新しいタスクに適応すること(継続学習)が期待されていますが、現在のマルチモーダルAIでは、継続的に発生する要件に対し適応することができていません。

したがって、モデルの追加学習にかかる莫大なコストを回避しつつ、新しいデータを効率的かつ継続的に活用させる柔軟性をモデルに与えるアプローチが必要不可欠になります。

しかし、追加する新しいタスクを学習するときに、モデルが以前の知識を忘れる「破滅的忘却」の課題が発生しており、どのようにして抑制していくかが課題になってきます。これを解決することで、より身近にマルチモーダルAIが活躍していくでしょう。

モデルの軽量化

マルチモーダルAIをリソースに制約のあるプラットフォーム(低電力なモバイルやIoTデバイス等)に導入し、同時に最適な性能を達成するには、モデルの軽量実装も必要になります。

これに対して、MobileVLMというモデルの開発が進んでいます。

このモデルは、ベースとなるLLaVAをダウンスケールし軽量化を行っており、2,000万未満のパラメータで構成されるDownsample Projectorを用いることで、計算速度も向上しています。

具現化された知性

マルチモーダルAIをロボットに搭載させることで、AIが身体性を獲得し、人間の様な知覚と周囲との相互作用を再現することが可能です。例えば、視覚的な質疑応答や身体制御などのAIタスクにより、ロボットがリアルタイムに状況を視覚による把握で、タスクを自動的に実行できるようになります。

これらの研究としては、PaLM-EやEmbodiedGPTがあります。PaLM-E9は、Googleが開発した大規模言語モデルPaLMを、ロボットがカメラや腕などのセンサーから取り込むデータで補完することで、タスクを実行させることができ、人間の声で命令したことも実行することができます。

しかし、PaLMのサイズが巨大なため(パラメータ数が最も大きいサイズのモデルで5,400億)、より複雑な処理を追加することが難しいが、Google社はPaLMをマルチモーダルにするのではなく、PaLMと別のVision Model(Vision Transformer、パラメータ数は220億個)を組み合わせることで効率化させ、マルチモーダルなPaLM-Eを開発しました。

このような効率化されたAIの登場が多くなることで、人間のようなやり取りに近いコミュニケーションが取れるように進化していき、介護などの現場をはじめとする多くのシチュエーションで活躍する可能性があります。

ここまでマルチモーダルAIの歴史やLLMとの親和性について解説してきました。マルチモーダルAIやLLMのビジネス活用についてのご相談を随時お受けしています。是非お気軽にお問合せ下さい!